Künstliche Intelligenz (KI) steckt heutzutage bereits in vielen Systemen: vom Sprachassistenten bis hin zu intelligenten Algorithmen, die unser Verhalten beim Online-Shopping oder in Social Media auswerten. In Zukunft werden uns KI-Systeme noch viel häufiger begegnen und das insbesondere in kritischen Anwendungsfeldern, wie autonomem Fahren, Produktionsautomatisierung/Industrie 4.0 oder Medizintechnik. Kritisch sind diese Anwendungsfelder, weil ein Fehlverhalten des KI-Systems zu einer Gefahr für Leib und Leben werden kann; beispielsweise, wenn ein autonom fahrendes Fahrzeug einen Menschen beim Überqueren einer Straße nicht erkennt oder wenn ein autonomer OP-Roboter eine Fehlfunktion bei einer Operation hat. Im folgenden Beitrag zum Thema »Dependable AI / Verlässliche KI« soll insbesondere der Aspekt der Absicherung von KI-Systemen diskutiert werden.

In diesem Blog-Artikel sollen die typischen Herausforderungen bezüglich der Sicherheit oder auch bezüglich anderer Eigenschaften der Verlässlichkeit in Anbetracht von KI-Systemen thematisiert werden. Zugleich zeigen wollen wir auch Lösungsvorschläge aufzeigen, die es uns ermöglichen, KI in kritischen Anwendungsfeldern verlässlicher zu machen. Zunächst beschäftigen wir uns aber mit der Frage, was KI-Systeme eigentlich sind und auf welche Qualitäten man in welchen Anwendungsfeldern achten muss.

Was sind KI-Systeme?

KI-Systeme sind Systeme, die eine Künstliche Intelligenz beinhalten; d.h., mindestens eine Komponente des Systems setzt eine Funktionalität mittels Künstlicher Intelligenz um.

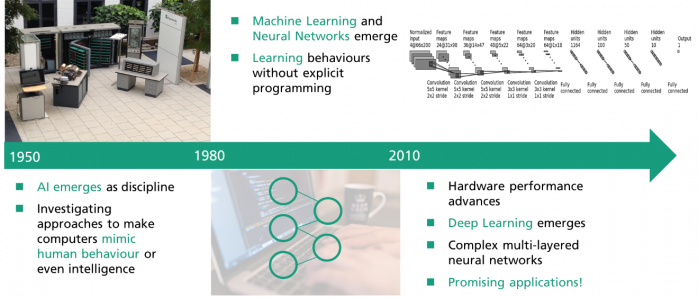

KI ist eine breite und in Informatikmaßstäben eher alte Disziplin (siehe Abbildung 1), welche viele verschiedene Arten von Ansätzen subsumiert. Im Kern geht es bei jedem dieser Ansätze darum, menschliches Verhalten nachzuahmen. Intelligenz im eigentlichen Sinne wird von den Ansätzen in der Regel jedoch nicht erreicht, wobei es aber natürlich schon ein Ziel der Forschung ist, auch in dieser Hinsicht Fortschritte zu machen. In den letzten Jahren ist die KI Aufgrund vieler neuer Anwendungserfolge erneut stark in den Blickpunkt gerückt. Diese Erfolge wurden in erster Linie durch Fortschritte in den Bereichen des Maschinellen Lernens und insbesondere bei den Neuronalen Netzen erzielt. Hier wird die Funktionalität auf Basis von Daten gelernt und nicht mehr klassisch programmiert.

Beispiele für erfolgreiche Anwendungen sind insbesondere bei der semantischen Segmentierung von z.B. Bilddaten, also zum Beispiel der Objekterkennung auf Basis von Bildinformationen, zu finden. Dieser Bereich wird zunehmend wichtig, da die Wahrnehmung der Umgebung für die stark aufkommenden hochautomatisierten und autonomen Systeme essenziell ist. Und auch im medizinischen Bereich gibt es bereits sehr vielversprechende Resultate. Hier unterstützen KI-Komponenten erfolgreich bei Diagnosen auf Basis von bildgebenden Untersuchungen wie MRT oder CT.

Insgesamt kann man sagen, dass die Nutzung des Maschinellen Lernens (ML) oftmals dort vielversprechend ist, wo es schwierig ist, eine adäquate konventionelle Spezifikation einer Komponente zu erstellen. ML ermöglicht dann also Funktionalitäten, die auf klassischem Weg nicht oder nur schlechter mit Software programmiert werden könnten. Damit können komplexe Zusammenhänge (in Modellen) realisiert werden, die dann in KI-Systemen zum Einsatz kommen.

Welche Qualitäten eines KI-Systems sind für welche Anwendung wichtig?

In der Praxis gibt es eine Vielzahl möglicher KI-Anwendungen aus verschiedenen Anwendungsdomänen. Im Folgenden wollen wir uns die Vorteile und Gefahren eines KI-Systems anhand dreier Beispiele aus ganz verschiedenen Bereichen anschauen:

(1) In einer intelligenten Fabrik sagt ein KI-System z.B. den Ausfall einer Maschine in einer Produktionsstraße auf Basis von Sensordaten voraus. Man spricht hier von Predictive Maintenance – also der vorausschauenden Wartung einer Maschine. Damit wird es möglich, dass die Produktionsstraße für ein Produkt nicht ungeplant ausfällt und hohe Stillstandkosten verursacht, sondern die Wartung der Maschine zu einem günstigen Zeitpunkt vor dem Ausfall eingeplant werden kann. Eine fehlerhafte Vorhersage der KI führt dann bei einer falsch-positiven Vorhersage zu unnötigen Wartungskosten oder bei einer falsch-negativen Vorhersage zu einem ungeplanten Stillstand der Maschine. In beiden Fällen sprechen wir von etwaigen materiellen Verlusten. Bei der Qualität des KI-Systems geht es also im Wesentlichen um die Genauigkeit der Vorhersage und die Effizienz der Maschine. Predictive Maintenance gewinnt in Deutschland im Zuge der Industrie 4.0 zunehmend an Bedeutung. Bei der vierten industriellen Revolution werden z. B. Daten über einen Digitalen Zwilling der produzierenden Maschinen in großen Mengen verfügbar. Diese können wiederum für den Bau von Modellen genutzt werden.

(2) In den USA wurden KI-Systeme zur Vorklassifikation von Bewerber*innen bei Unternehmen eingesetzt. Der Vorteil des KI-Einsatzes liegt darin, dass bei einer sehr großen Anzahl an Bewerber*innen die scheinbar interessanten automatisch herausgefiltert werden – ein Prozess, der ansonsten aufwändig manuell durchgeführt werden muss. In der Praxis hat sich allerdings bei einigen dieser Systeme gezeigt, dass systematisch einige gesellschaftliche Gruppen diskriminiert wurden. Das lag daran, dass die Daten, auf deren Basis diese Systeme angelernt wurden, bereits gewisse Ungerechtigkeiten enthielten und diese demzufolge auch im KI-Modell steckten. Die Empfehlungen der KI führten so zum Ausschluss und zur Ungleichbehandlung aufgrund nichtfachlicher Argumente, wie z.B. der Zugehörigkeit zu einer ethnischen Gruppe. Die KI-Qualitäten, die bei der Klassifikation von Bewerber*innen im Vordergrund stehen sollten, sind Fairness und Gleichbehandlung. Das Beispiel zeigt auch, dass es nicht allein auf die Genauigkeit der Klassifikation ankommt, sondern darauf, dass auch die Daten, die zum Anlernen von Modellen genutzt werden, gewisse Qualitäten aufweisen sollten.

(3) Das dritte Beispiel ist weltweit und insbesondere in Deutschland in aller Munde: Beim automatisierten oder autonomen Fahren ist die KI ein wichtiger Enabler. Hier geht es insbesondere um den zentralen Aspekt der Perzeption, aber auch im Bereich des automatisierten Fahrverhaltens sind Anwendungen denkbar. Das Potenzial des autonomen Fahrens ist groß. Es bietet zum Beispiel die Grundlage für komplett neu gedachte zukünftige Mobilitätskonzepte wie Mobility as a Service. Damit würde sich die Mobilität jedes Einzelnen, aber auch die komplette Mobilitätswirtschaft grundlegend ändern. Im Vergleich zu den beiden anderen Beispielen kann hier allerdings ein Fehler des KI-Systems nicht nur zu einem materiellen Schaden führen, sondern zur Gefahr für Leib und Leben werden – für das der Insassen sowie weiterer am Straßenverkehr beteiligter Personen. Es geht also darum, Fehler oder Fehlverhalten in einem akzeptablen Maß zu halten. Im Fachjargon geht es um die Funktionale Sicherheit des Systems (Absicherung bezgl. aus Fehlfunktionen resultierender Gefährdungen; siehe ISO 26262) oder engl. Functional Safety, aber auch um die Sicherheit der Normalfunktion, welche aktuell unter dem Begriff Safety of the Intended Functionality adressiert wird (siehe ISO 21448). Abseits der Safety sind im Kontext der zukünftigen Mobilität aber natürlich auch andere Qualitäten wie Verfügbarkeit oder Datenschutz sehr wichtig.

Wie unsere Beispiele zeigen, ergeben sich also je nach Anwendungsfeld unterschiedliche Qualitätsanforderungen an KI-Systeme. In einigen Bereichen, wie z.B. der funktionalen Sicherheit, gibt es bereits eine Vielzahl von Normen, die beschreiben, wie sicherheitsrelevante Softwaresysteme zu entwickeln sind (wie z.B. die IEC 61508 für funktionale Sicherheit im Allgemeinen oder die ISO 26262 im Automobilbereich).

Aber selbst Vorgaben – sofern sie existieren – sind für KI-Systeme nicht immer passend, oder sie sind unvollständig, da KI-Komponenten eines Systems fundamental anders entwickelt werden: Die Funktionalität wird insbesondere nicht programmiert, sondern durch das Anwenden von Algorithmen auf Daten erstellt. Dadurch entsteht ein Modell, das von der Software zur Laufzeit lediglich ausgeführt wird. Das resultierende Modell ist aufgrund seiner inhärenten Komplexität im Allgemeinen für den Menschen nicht verständlich. Damit sind die Entscheidungen eines KI-Systems oft nicht transparent. Zudem können die Anforderungen an das KI-System typischerweise nicht vollständig beschrieben werden. Dennoch muss ein KI-System in einem schier unendlichen Anwendungsraum verlässlich funktionieren. Hier kommen etablierte Methoden und Techniken des klassischen Softwaretestens an ihre Grenzen. Ganz kritisch wird es bei selbstlernenden Systemen, also Systemen, die zur Laufzeit dazu lernen und ihr Verhalten anpassen. Auch hier gibt es Beispiele: Zum Beispiel hat ein KI-Chatbot rassistische Ansichten gelernt. Technisch gesehen hatte der Chatbot zwar keine Fehlfunktion, aber “Every program has (at least) two purposes: the one for which it was written and another for which it wasn’t“ (Alan J. Perlis, 1982). Daraus ergibt sich “We had better be quite sure that the purpose put into the machine is the purpose which we really desire” (Norbert Wiener, 1960).

Trotz der Vielzahl an Anwendungsmöglichkeiten gilt es also, etwaige Risiken beim KI-Einsatz genau zu analysieren und schon bei der Konzeption des KI-Systems entsprechend abzusichern.

Was versteht man unter verlässlicher KI bzw. Dependable AI?

Dependability oder die Verlässlichkeit eines Systems beschreibt die Fähigkeit, nicht akzeptable Fehler bei der Erbringung eines Dienstes oder einer Funktionalität zu vermeiden (Jean-Claude Laprie). Dependability beinhaltet dabei z.B. die Verfügbarkeit oder Zuverlässigkeit eines Dienstes, aber insbesondere auch die funktionale Sicherheit (Safety), um katastrophale Folgen für die Nutzer und die Umgebung zu vermeiden (also schwerwiegende oder gar tödliche Unfälle als Folge von Fehlern). Aber auch die Integrität und Zugriffssicherheit (Security) eines Systems oder dessen Wartbarkeit sind Qualitätseigenschaften, die im Kontext von Dependability genannt werden.

Beim Engineering verlässlicher KI-Systeme geht es entsprechend darum, mittels Prinzipien aus dem Systems- und Software-Engineering bei der Konstruktion, der Verifikation/Validation und dem Betrieb von KI-Systemen die Verlässlichkeit systematisch zu gewährleisten und insbesondere auch gesetzliche und normative Vorgaben bzgl. der Verlässlichkeit von Beginn an zu berücksichtigen.

Hören Sie auch in unserem Podcast MORGEN DENKER mehr zu Dependable AI. Im Interview: Dr. Jens Heidrich, Division Manager Smart Digital Solutions am Fraunhofer IESE

Welche Möglichkeiten eröffnen sich durch verlässliche KI bzw. Dependable AI?

Die Anwendungsfelder von KI im Allgemeinen sind vielfältig: In den Zukunftsszenarien fast aller Branchen spielt KI eine entscheidende Rolle – ob Smart Mobility, Smart Production/Industrie 4.0, Digital Health, Smart Farming, Smart City oder Smart Region. Die meisten Szenarien basieren darauf, dass datenbasierte intelligente Systeme angelernt werden, die aufgrund ihrer Komplexität nicht durch klassisches Programmieren konstruiert werden können. Mit Verfahren wie dem Maschinellem Lernen wird versucht, ein hoch komplexes Problem zu lösen, indem Modelle auf einer riesigen Menge von Daten erlernt werden.

KI-Ansätze können dabei dazu verwendet werden, entweder existierende Prozesse zu optimieren (wie effizientere Wartung von Maschinen oder Sortierung von Werkstücken) oder vollkommen neue nutzerorientierte Produkte und Dienste zu schaffen (wie intelligente Mobilitätsdienste auf Basis von autonomen Fahrzeugen).

Die Potenziale, die KI für die Wirtschaft beinhaltet, wurden in verschiedensten Studien untersucht. Diese Studien sagen für die nächsten Jahre sowohl für Deutschland als auch weltweit ein starkes Wachstum vorher. Ein Großteil des Zuwachses wird durch völlig neue und stärker nutzerorientierte Produkte erwartet. Das Potenzial ist gewaltig, aber auch die Konkurrenz im globalen Wettbewerb ist groß. Länder wie die USA und China investieren in großem Maßstab und sind aufgrund ihrer Strukturen und ihrer Mentalität ein günstiges Umfeld für Start-ups und die schnelle Etablierung neuer innovativer Produkte und Services. Um sich im Wettbewerb zu behaupten, müssen sich Europa und Deutschland daher auf eigene Stärken besinnen: ingenieurmäßig entwickelte Qualität und Verlässlichkeit!

Denn für viele der eingangs erwähnten Zukunftsszenarien ist Dependable AI entscheidend für den Erfolg. Dies betrifft zum Beispiel alles rund um hochautomatisierte bzw. Autonome Systeme und kognitive Systeme in sicherheitskritischen Anwendungsfeldern. Ohne Verlässlichkeit kein Vertrauen (Trust und Trustworthiness) und ohne Vertrauen keine Akzeptanz und kein Erfolg. Schließlich würde kaum jemand autonome Fahrzeuge nutzen oder mit lernfähigen Robotern im Arbeitsumfeld zusammenarbeiten, wenn diese nicht grundsätzlich sicher sind, was ihre Funktionsweise im dafür vorgesehenen Umfeld (wie im Straßenverkehr oder in der Fabrik) betrifft.

Für die Zukunft eines Unternehmens ist es heute wichtiger denn je zu wissen, wo das Potenzial beim KI-Einsatz im jeweiligen Anwendungsbereich liegt und mit welchen Verfahren man verlässliche KI-Systeme bauen kann. Hier nehmen Deutschland und Europa mit der sehr ausgeprägten Forschung im Bereich »Dependability« und »Safety« eine Vorreiterrolle ein.

Welche Herausforderungen müssen bei der Entwicklung verlässlicher KI-Systeme beherrscht werden?

Die Herausforderungen bei der Entwicklung von KI-Systemen im Allgemeinen und verlässlichen KI-Systemen im Besonderen sind vielschichtig. Sie reichen von der KI-Strategie über konkrete technische Fragestellungen zur Absicherung des KI-Systems bis hin zu den verfügbaren Kompetenzen im Unternehmen. Wir sehen diesbezüglich die folgenden Top 10 (in keiner bestimmten Reihenfolge) der typischen Praxisprobleme :

- Potenziale und Risiken: KI und Maschinelles Lernen sind mehr als eine rein technische Herausforderung, die nicht mit dem Kauf von Werkzeugen und Infrastruktur beginnen sollte. Unternehmen stehen oft vor der Herausforderung, einen für sie nutzbringenden Anwendungsfall zu finden oder zu bewerten, inwieweit KI für einen gegebenen Anwendungsfall wirklich die Lösung sein kann. Ferner ist es für Unternehmen eine Herausforderung zu bewerten, wie sich KI auf ihr Geschäft auswirken könnte und welche Mehrwerte in der Nutzung liegen. Es bedarf einer KI-Strategie, in der Potenziale und Risiken klar ersichtlich werden.

- Nachweis der Verlässlichkeit: Ein Kernelement bei der Konstruktion verlässlicher KI-Systeme ist der Nachweis der Verlässlichkeit. Es muss stichhaltig und nachvollziehbar dargelegt werden, dass alle diesbezüglich relevanten Anforderungen korrekt identifiziert wurden und dass das System diese Anforderungen, untermauert durch entsprechende Evidenzen, tatsächlich erfüllt. Mit anderen Worten, es wird eine umfassende Argumentation benötigt, welche alle bezüglich der Verlässlichkeit relevanten Belange organisiert und strukturiert.

- Sicherheitsarchitekturen: Auch wenn eine KI-Komponente ein Fehlverhalten zeigt, muss das System als Ganzes in der Lage sein, mit diesem Fehlverhalten umzugehen und ein etwaiges Schadensrisiko geringhalten. Der Entwurf solcher Sicherheitsarchitekturen, die ausschlaggebend dafür sind, dass das System als Ganzes verlässlich funktioniert, ist in der Praxis oftmals herausfordernd.

- Blackbox-Komponenten: Große Systeme werden heutzutage selten von einem einzelnen Hersteller gebaut, sondern integrieren Teile von Zulieferern. Oftmals werden in diesem Zusammenhang Softwarekomponenten als Blackbox ausgeliefert; d.h. es gibt keinen Einblick in die konkrete Umsetzung und es lässt sich nur das Verhalten der einzelnen Komponenten beobachten. Bei KI-Komponenten ist es daher wichtig, dass Zusicherungen und Angaben zur Verlässlichkeit der jeweiligen Komponente eindeutig spezifiziert und zusammen mit der Komponente ausgeliefert werden.

- Dynamisches Risikomanagement: Um das Risiko von Fehlern und Fehlverhalten eines KI-Systems in einem akzeptablen Maß zu halten, kann es aufgrund bestehender Unsicherheiten zur Entwicklungszeit nötig sein, sehr konservative Worst-Case-Abschätzungen zu treffen, was natürlich die Performanz des Systems negativ beeinträchtigen kann. Abhilfe besteht darin, das System in die Lage zu versetzen, diese Unsicherheiten zur Laufzeit aufzulösen und dann einerseits die Verlässlichkeit aktiv zu gewährleisten, andererseits aber auch die Performanz zu optimieren. Die Nutzung solcher Laufzeitmaßnahmen stellt in der Praxis zunächst eine Herausforderung dar, birgt aber auch oft großes Potenzial.

- Unsicherheitsbewertung: Jedes datenbasierte Modell hat bei der Anwendung gewisse Unsicherheiten. Diese können neben dem KI-Modell selbst auch aus den Eingabedaten und dem Verwendungskontext stammen. Beispielsweise kann es sein, dass ein Modell für bestimmte Eingabedaten nicht trainiert wurde oder außerhalb des vorgesehenen Verwendungskontexts genutzt wird. Eine Herausforderung liegt darin, diese Unsicherheiten zu quantifizieren, um das von ihnen ausgehende Risiko zu beherrschen.

- Datenverfügbarkeit: Oftmals fehlt es auch an qualitativ hochwertigen Daten bzw. an Wissen darüber, wie solche Daten erfasst werden können. Für den Bau von Modellen mit Maschinellem Lernen stellt das ein großes Problem dar. Auch der beste Ansatz für Maschinelles Lernen kann aus qualitativ schlechten Daten kein erstklassig funktionierendes Modell erzeugen.

- Data-Science-Kompetenzen: Die Nachfrage nach Data Scientists, also Personen mit Kompetenzen im Umgang mit Daten und insbesondere Big Data sowie deren Analyse und Modellbildung, ist groß. Für Unternehmen ist es häufig eine Herausforderung, Data Scientists anzuwerben oder innerhalb des Unternehmens über Weiterbildungen aufzubauen. Dies gilt insbesondere für Data Scientists, die sich mit der Konstruktion verlässlicher KI-Systeme auskennen.

- KI-Standards: Für Dependable AI, also die Absicherung von KI-Systemen, fehlen zudem noch gesetzliche Vorgaben, Normen, Best Practices und etablierte Methoden. Einige Leitlinien wurden gerade erst veröffentlicht (z.B. die Ethikrichtlinien für vertrauenswürdige KI) oder müssen noch in Bezug auf KI angepasst werden (wie die Neufassung der ISO 26262 oder die Erweiterung der ISO/IEC 25000-Serie in Bezug auf KI). Daher ist für viele Unternehmen nicht klar, welche KI-Systeme heute schon möglich sind und wie die zukünftigen Vorgaben für verlässliche KI-Systeme aussehen werden.

- Referenzprozesse: In der angewandten KI-Forschung gibt es viele parallele Entwicklungen, die verfolgt werden müssen. Für etliche Probleme gibt es dort individuelle, lokale Lösungen, aber ein umfassender Engineering-Prozess, der sich für den industriellen Einsatz eignet, ist aktuell noch nicht verfügbar. Unternehmen können sich daher nicht an einem Referenzprozess orientieren und müssen sich mühsam eine eigene Blaupause für die Entwicklung ihres KI-Systems zusammenstellen.

Bei welchen Anwendungen steht die Verlässlichkeit des KI-Systems im Fokus?

Typische Anwendungsfelder für Dependable AI sind Systeme, bei denen es um die Verlässlichkeit des KI-Systems – also die Beherrschung des Risikos von Fehlern oder Fehlverhalten – geht.

Smart Mobility: Hochautomatisierte und autonome Fahrzeuge werden die Bereiche Mobilität und Logistik (Warentransport) vollständig verändern und neue digitale Dienste entstehen lassen. Aber die Risiken eines solchen Fahrzeugs müssen für Nutzende und mit dem Fahrzeug interagierende Personen (wie Passanten) akzeptabel sein. Was genau ein akzeptables Risiko ist, wird aktuell noch diskutiert, z.B. auch von Ethikkommissionen. Grundlegende Elemente, die bereits weithin akzeptiert werden, sind die positive Risikobilanz (Positive Risk Balance) und das Prinzip ALARP (As Low as Reasonably Practicable). Bei der positiven Risikobilanz wird sichergestellt, dass die Gefahren für Leib und Leben geringer sind, als wenn eine Person das System manuell bedienen würde. Bei ALARP muss nachgewiesen werden, dass alles zur Risikominderung getan wird, was vernünftigerweise – je nach Machbarkeit und Aufwand – getan werden kann.

Industrie 4.0: KI ist einer der Stützpfeiler der vierten industriellen Revolution hin zu einer intelligenten Fabrik, die hochflexibel individualisierte Produkte entstehen lässt. Neben Szenarien wie Production-as-a-Service oder Predictive Maintenance werden auch neue intelligente Maschinen eingesetzt. Fahrerlose Transportsysteme planen ihre Fahrten eigenständig und passen diese an die Nachfrage an. Cobots unterstützen Fabrikarbeiter und können effizient für verschiedenste Arbeiten angelernt werden. Heutzutage werden Mechanismen wie Lichtschranken und Sicherheitskäfige benutzt, die das System völlig deaktivieren, sollte ein Mensch in die Schutzzone gelangen. Somit kann allerdings der gewünschte Grad der engen Interaktion mit dem Menschen nicht erreicht werden. Zukünftig bedarf es auch intelligenterer Schutzfunktionen bei der Benutzung von und der Interaktion mit solchen Systemen, damit ein Mensch keinem erhöhten Risiko ausgesetzt wird.

Digital Health: Schon heute werden Mediziner bei der Prävention, Diagnose und Therapie von Krankheiten durch KI-Systeme unterstützt. Die KI ist dabei oft für fortgeschrittene Bild- und Datenauswertung (z.B. bei der Interpretation eines CT-Bildes) zuständig. Sie erlaubt qualitativ hochwertige Analysen in einer Häufigkeit, die auf herkömmlichem Wege nicht zu erreichen sind. Selbst bei Operationen werden heute schon erste Robotersysteme eingesetzt, die jedoch vom Menschen kontrolliert werden. Doch je mehr sich Mediziner auf solche Systeme stützen und je höher zukünftig der Autonomiegrad von KI-Systemen wird, desto wichtiger wird die Beherrschung des Risikos eines Fehlers und eines Fehlverhaltens der KI.

Wie erfolgt die Entwicklung verlässlicher KI-Systeme?

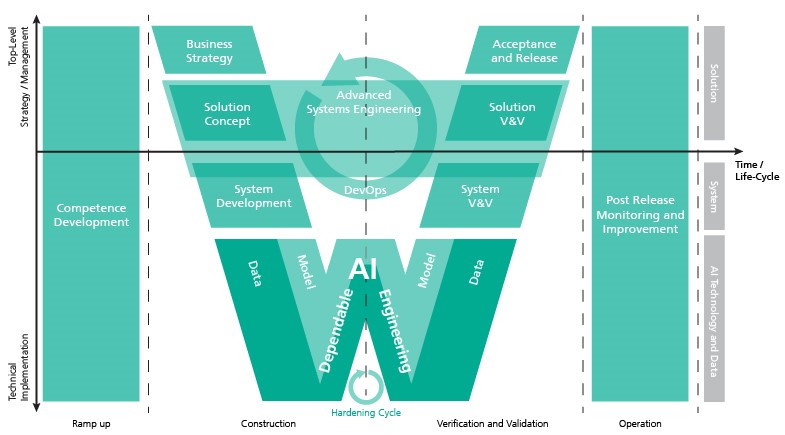

Bei der Absicherung eines verlässlichen KI-Systems müssen verschiedenste Verfahren bei der Konstruktion, der Verifikation/Validation (V&V) und beim Betrieb in Abhängigkeit von der Kritikalität der Funktionalität des Systems angewandt werden. Abbildung 2 zeigt grundlegende Prozessbereiche in einem W-Modell. Dabei unterscheiden wir verschiedene Aktivitäten im Lebenszyklus eines KI-Systems (X-Achse) und verschiedene Stakeholder, die in den unterschiedlichen Phasen beteiligt sind: von der Managementebene bis hin zur operativen/technischen Ebene. Die Darstellung der Aktivitäten und Ebenen orientiert sich an der VDE-AR-E 2842-61, welche ein Referenzmodell für vertrauenswürdige KI definiert (entwickelt von der DKE, der in VDE und DIN zuständigen Organisation für die Erarbeitung von Normen). Grundsätzlich orientiert sich der Prozess an einem ganzheitlichen Systems-Engineering-Ansatz. Dabei ist es je nach Anwendungsfeld üblich, dass einzelne Systemkomponenten als Blackbox von Zulieferern in das Gesamtsystem integriert werden müssen.

Strategie: Der Gesamtprozess beginnt mit der Erstellung der Geschäftsstrategie und dem Herausarbeiten der konkreten Potenziale/Mehrwerte, die von einem KI-System erwartet werden. Daraus werden technische Anforderungen auf Systemebene und ein konkretes Lösungskonzept abgeleitet.

Verlässlichkeitsanalysen: In Abhängigkeit von der Kritikalität des Systems werden auf Systemebene weitere Analysen (z.B. bzgl. funktionaler Sicherheit) durchgeführt, um die Anforderungen bezüglich der Verlässlichkeit systematisch zu erheben und um die regulatorischen und gesetzlichen Vorgaben bei der Entwicklung zu berücksichtigen. Hier würden beispielsweise Hazard and Risk Analysis (HARA; funktionale Sicherheit) oder Threat Analysis and Risk Assessment (TARA; Security) durchgeführt werden, um die übergeordneten Safety- und Security-Anforderungen zu identifizieren. Auf Basis dieser und weiterer Analysen sollte dann die Grundstruktur der Verlässlichkeitsargumentation erzeugt werden. Die Anforderungen werden später gemäß der Systemarchitektur und gestützt durch etablierte Techniken wie FMEA und FTA weiter heruntergebrochen und an Systemkomponenten allokiert. So erhalten auch KI-Komponenten dedizierte Anforderungen bezüglich ihrer Verlässlichkeit.

Konstruktion: Das System wird im Rahmen klassischer Ansätze des Systems Engineerings (wie ISO/IEC 15288 oder 12207) in Teilsysteme zerlegt, die aus Software und Hardware bestehen können. Diese Software-Teilsysteme bestehen wiederum aus klassischen Softwarekomponenten und solchen, die KI beinhalten und eine Normal- oder Sicherheitsfunktion des Systems abbilden. Softwarekomponenten werden heutzutage in einem agilen Entwicklungsprozess erstellt (wie z.B. Scrum), der parallel zur Entwicklung der Hardware erfolgt. Auch KI-Komponenten werden üblicherweise in einem hoch iterativen Prozess entwickelt, der sich aber eher an gängigen Vorgehen aus dem Bereich Data Science orientiert (wie CRISP-DM). Wenn Verfahren des Maschinellen Lernens verwendet werden sollen, bedarf es zunächst eines geeigneten Trainingsdatensatzes. Dieser sollte basierend auf den Anforderungen systematisch erstellt werden, denn bereits bei den Daten, die genutzt werden, um ein KI-Modell anzulernen, können bestimmte Qualitäten sichergestellt werden (z.B. in Bezug darauf, dass Daten verwendet werden, welche die intendierten Nutzungskontexte entsprechend ausreichend abdecken). Das entsprechende Vorgehen sollte in der Verlässlichkeitsargumentation entsprechend dokumentiert werden. Ausgehend von dem initialen Trainingsdatensatz sollte das Modell inkrementell/iterativ solange verbessert werden, bis es die vorgegebenen Qualitätskriterien einhält. Man spricht in diesem Zusammenhang von der Evaluation bzw. Härtung des KI-Modells. Bezüglich der Evaluation kommen Testdatensätze und ggfs. weitere analytische Techniken, wie zum Beispiel aus dem Bereich der Explainable AI (XAI), zum Einsatz. Auf Basis der Ergebnisse erfolgen Anpassungen der Trainingsdaten und ein erneutes Training. Dies kann mehrfach wiederholt werden und auch Hand in Hand mit anderen Maßnahmen auf Architekturebene gehen.

Ein zentrales Element für die Sicherstellung einer Dependable AI stellt die Systemarchitektur dar. Hier gibt es z.B. Architekturen, die eine Art Sicherheitscontainer um die KI legen. Diese Safety-Supervisor- oder Simplex-Architekturen überschreiben die KI-Entscheidung, falls diese zu einem gefährlichen Verhalten des KI-Systems führen würde. Dazu ist es wichtig, z.B. die Unsicherheit der KI-Empfehlung unter bestimmten Nutzungsbedingungen zu kennen und darauf basierend das Risiko einer fehlerhaften Entscheidung zu ermitteln. Die Entwicklung solcher Maßnahmen zur Absicherung ist eng mit der Entwicklung der KI-Komponente verzahnt. Erkannte und gemäß den Anforderungen der Verlässlichkeit besonders kritische Schwachstellen werden gezielt adressiert. Letztlich muss die Kombination aus KI-Komponenten und (konventionellen) Maßnahmen zur Absicherung so gestaltet sein, dass eine stichhaltige Argumentation bezüglich der Einhaltung der Anforderungen möglich ist.

Systemintegration und Qualitätssicherung: Anschließend werden die Einzelkomponenten des Systems zum Gesamtsystem integriert und im Ganzen validiert. Erst dann kann das System nach Durchlauf definierter Akzeptanz- und Release-Kriterien nach außen gegeben werden (z.B. nach geforderten Testing- und Auditing-Prozessen). Die Verlässlichkeitsargumentation wird mit den im Rahmen der Qualitätssicherung erarbeiteten Evidenzen finalisiert, damit die Einhaltung aller geforderten Anforderungen klar belegt werden kann. Eine Digital Dependability Identity (DDI) sammelt z.B. zentral alle Spezifikationen (formalisiert und verlinkt durch die Verlässlichkeitsargumentation als Assurance Case), die für die Dependability des jeweiligen Systems relevant sind und wird gemeinsam mit diesem ausgeliefert.

In der Praxis wird dieser Gesamtprozess zur Konstruktion und Verifikation/Validation je nach Größe und Komplexität des Systems und des Entwicklungsprojekts auch mit mehreren Iterationen durchlaufen.

Betrieb: Der Lebenszyklus eines KI-Systems endet nicht mit der Bereitstellung des Systems. Während der Betriebsphase geht es darum, das aktuelle Risiko und die Performanz des Systems zu überwachen und aus dem tatsächlichen Verhalten zu lernen, wie das KI-System bzw. KI-Modell verbessert werden kann (z.B. Field Feedback, DevOps oder Continuous Engineering). Wir sprechen hier von Dynamic Risk Management, welches feingliedrig in das Verhalten des Systems eingreifen kann, um ein potenziell erhöhtes Risiko wieder mittels entsprechender Gegenmaßnahmen (wie z.B. Fahren mit geringerer Geschwindigkeit) zu reduzieren. Gibt es andererseits zu einem bestimmten Zeitpunkt ein nur sehr geringes Risiko, kann die Performanz (wieder) erhöht werden (also z.B. Fahren mit höherer Geschwindigkeit). Mechanismen zur Laufzeit werden noch wichtiger, wenn wir in die Zukunft schauen und von KI-Systemen sprechen, die über ihre Laufzeit hinweg weiterlernen und demzufolge ihr Verhalten anpassen können. Da man potenziell zum Entwurfszeitpunkt des KI-Systems nicht wissen kann, auf Basis welcher Daten die KI weiterlernt, müssen entsprechende Leitplanken für das Verhalten definiert und in entsprechende Mechanismen in die Laufzeit gebracht werden, welche dynamisch das Risiko von Fehlverhalten minimieren.

Fazit

Die Nutzung von KI-Systemen eröffnet große Möglichkeiten und verspricht in den nächsten Jahren ein hohes Wirtschaftswachstum. Gleichzeitig herrscht aber auch ein harter globaler Wettbewerb. In Deutschland liegt ein starker Fokus auf industriellen KI-Anwendungen, wie in der Mobilität/Logistik, der Industrie 4.0 oder der Medizintechnik. Gerade in diesen Branchen ist es von essenzieller Bedeutung, dass KI-Systeme sicher, verlässlich und vertrauenswürdig sind.

Um diese Qualitäten zu garantieren und das Risiko eines KI-Systems transparent und beherrschbar zu machen, müssen einige grundlegende Fragen aus Sicht eines Unternehmens beantwortet werden:

- Welchen Mehrwert bietet der Einsatz von KI für mein Unternehmen und wie wirkt sich das auf mein Geschäftsmodell aus?

- Was sind relevante Normen/Standards/Qualitätsrichtlinien, die eingehalten werden müssen?

- Welche Daten brauche ich in welcher Qualität, und lassen sich daraus geeignete KI-Modelle für die beabsichtigten KI-Anwendungen konstruieren?

- Wie sieht der Gesamtprozess für das Engineering verlässlicher KI-Systeme aus, welcher notwendige Kompetenzen aus dem Systems- und Software-Engineering sowie Data Science multidisziplinär zusammenbringt?

- Wie kann ich eine Verlässlichkeitsargumentation mit geeigneten Evidenzen für mein KI-System aufbauen?

- Wie gehe ich insbesondere bezüglich der sicherheitsgerichteten Entwicklung von Systemen mit KI-Komponenten vor und wie steht dies in Bezug zu etablierten Safety-Normen und -Standards?

- Welche Qualitäten können zur Entwicklungszeit des KI-Systems betrachtet werden und was muss ich zur Laufzeit überwachen?

- Wie sieht die Architektur meines KI-Systems aus, um die geforderten Normen/Standards/Qualitätsrichtlinien geeignet umzusetzen?

- Wie bewerte ich die reale Performanz meines KI-Systems im Betrieb und wie verbessere/warte ich das KI-Modell (DevOps)?

- Welche Kompetenzen brauche ich im Unternehmen, um meine KI-Anwendungsszenarien zu realisieren und zu warten?

Ganzheitliche Referenzmodelle (wie das oben gezeigte W-Modell basierend auf VDE-AR-E 2842-61) helfen dabei, diese Fragen systematisch in einem iterativen, inkrementellen Entwicklungsansatz zu beantworten. Auch wenn an vielen Stellen noch weitere Forschungsarbeit notwendig ist, so sind doch schon heute viele konkrete Lösungsbausteine verfügbar, um verlässliche KI-Systeme zu konstruieren und zu betreiben.

Mehr zu Dependable AI

Einen umfassenden Überblick über »Verlässliche KI/Dependable AI« und die Lösungsbausteine des Fraunhofer IESE finden Sie hier:

Darüber hinaus greifen wir das Thema Dependable AI auch in unserem MORGEN DENKER-Podcast zum 25. Jubiläum des Fraunhofer IESE auf. Hören Sie gerne mal rein.

Falls Sie Fragen zu »Dependable AI« haben, nach Partnern im Rahmen öffentlich geförderter Forschungsvorhaben suchen oder ein konkretes Problem bei der Absicherung Ihres KI-Systems haben, zögern Sie nicht, unsere konkreten Ansprechpartner zu kontaktieren!

- Dr. Jens Heidrich (Division Manager »Smart Digital Solutions«)

- Dr. Daniel Schneider (Department Head »Safety Engineering«)

- Dr. Andreas Jedlitschka (Department Head »Data Science«)

______________________________________________________________________

Besuchen Sie außerdem unser Weiterbildungsangebot:

Innovatives Praxiswissen und notwendige Kompetenzen bei der Absicherung von KI in sicherheitskritischen Systemen vermittelt Ihnen außerdem unsere 4-tägige Schulung »Data Scientist Specialized in Assuring Safety« (zertifiziert).