Künstliche Intelligenz (KI) steckt heutzutage bereits in vielen Systemen: vom Sprachassistenten bis hin zu intelligenten Algorithmen, die unser Verhalten beim Online-Shopping oder in Social Media auswerten. In Zukunft werden uns KI-Systeme noch viel häufiger begegnen und das insbesondere in kritischen Anwendungsfeldern, wie autonomem Fahren, Produktionsautomatisierung/Industrie 4.0 oder Medizintechnik. Hier spielt Dependable AI – also die Beherrschung des Risikos von nicht akzeptablen Fehlern und Fehlverhalten von KI-Systemen – eine wichtige Rolle. Das Fraunhofer IESE berät und unterstützt Unternehmen beim Engineering verlässlicher KI-Systeme und begleitet sie über den gesamten Lebenszyklus hinweg: von der KI-Strategie über die KI-Entwicklung bis zur KI-Absicherung bzw. zum KI-Testing/Auditing und zur Erfüllung der gesetzlichen und normativen Vorgaben.

Verlässliche KI / Dependable AI –ganzheitliches Engineering zuverlässiger KI-Systeme

Von der KI-Strategie über die KI-Entwicklung bis zur KI-Absicherung bzw. zum KI-Testing und KI-Auditing

Wofür interessieren Sie sich?

Sie wollen Künstliche Intelligenz für Ihre Systeme einsetzen? Wir geben Ihnen Antworten auf die wichtigsten Fragen. Springen Sie über das Inhaltsverzeichnis zum nächsten Thema.

- Was versteht man unter Dependable AI und Engineering verlässlicher KI-Systeme?

- Was sind die Chancen für Unternehmen durch den Einsatz von Dependable AI?

- Welche Herausforderungen müssen bei der Konstruktion, der Verifikation / Validation und dem Betrieb von Dependable AI-Systemen beherrscht werden?

- Wie können verlässliche KI-Systeme entwickelt werden?

- Wie kann das Fraunhofer IESE mein Unternehmen bei Dependable AI konkret unterstützen?

- Warum sollte mein Unternehmen für Dependable AI mit dem Fraunhofer IESE zusammenarbeiten?

- Welche Referenzen hat das Fraunhofer IESE?

Dependable AI und Engineering verlässlicher KI-Systeme:

Was versteht man darunter?

Definition

Dependability oder Verlässlichkeit eines Systems beschreibt die Fähigkeit, nicht akzeptable Fehler bei der Erbringung eines Dienstes oder einer Funktionalität zu vermeiden (Jean-Claude Laprie). Dependability beinhaltet dabei z.B. die Verfügbarkeit oder Zuverlässigkeit eines Dienstes, aber insbesondere auch die funktionale Sicherheit (Safety), um katastrophale Folgen für die Benutzer und die Umgebung zu vermeiden (also schwerwiegende oder gar tödliche Unfälle als Folge von Fehlern). Aber auch die Integrität und Zugriffssicherheit (Security) eines Systems oder dessen Wartbarkeit sind Qualitätseigenschaften, die im Kontext von Dependability genannt werden.

Beim Engineering verlässlicher KI-Systeme geht es entsprechend darum, mittels Prinzipien aus dem Systems- und Software-Engineering bei der Konstruktion, der Verifikation/Validation und dem Betrieb des KI-Systems die Verlässlichkeit systematisch zu gewährleisten und insbesondere auch gesetzliche und normative Vorgaben bzgl. der Verlässlichkeit von Beginn an zu berücksichtigen.

Dazu ist es wichtig zu verstehen, dass KI-Systeme fundamental anders entwickelt werden als klassische softwarebasierte Systeme. Häufig können die Anforderungen an das KI-System nicht vollständig beschrieben werden, und das System muss in einem schier unendlichen Anwendungsraum verlässlich funktionieren. Hier kommen etablierte Methoden und Techniken des klassischen Systems- und Software-Engineerings an ihre Grenzen und es bedarf neuer innovativer Ansätze. Die Funktionalität wird bei einer KI-Komponente nicht klassisch programmiert, sondern durch Anwenden von Algorithmen auf Daten erstellt. Es entsteht ein Modell, das von der Software zur Laufzeit lediglich ausgeführt wird. Ein diesbezüglicher Ansatz ist z.B. das Maschinelle Lernen (ML) oder spezieller auch das Deep Learning (DL). Das resultierende Modell (z.B. ein künstliches neuronales Netz) ist aufgrund seiner Struktur und seiner inhärenten Komplexität im Allgemeinen für den Menschen nicht verständlich und damit sind die Entscheidungen eines KI-Systems oft nicht nachvollziehbar.

Beispiele

Typische Anwendungsfelder sind Systeme, bei denen es um die Verlässlichkeit des KI-Systems – also die Beherrschung des Risikos von Fehlern oder Fehlverhalten – geht.

Smart Mobility

Hochautomatisierte und autonome Fahrzeuge werden die Bereiche Mobilität und Logistik (Warentransport) vollständig verändern und neue digitale Dienste entstehen lassen. Aber die Risiken eines solchen Fahrzeugs müssen für Benutzer und mit dem Fahrzeug interagierende Personen (wie Passanten) akzeptabel sein. Was genau ein akzeptables Risiko ist, wird aktuell noch diskutiert, z.B. auch von Ethikkommissionen. Grundlegende Elemente, die bereits weithin akzeptiert werden, sind die positive Risikobilanz (Positive Risk Balance) und das Prinzip ALARP (As Low as Reasonably Practicable). Bei der positiven Risikobilanz wird sichergestellt, dass die Gefahren für Leib und Leben geringer sind, als wenn eine Person das System manuell bedienen würde. Bei ALARP muss nachgewiesen werden, dass alles zur Risikominderung getan wird, was vernünftigerweise – je nach Machbarkeit und Aufwand – getan werden kann.

Industrie 4.0

KI ist einer der Stützpfeiler der vierten industriellen Revolution hin zu einer intelligenten Fabrik, die hochflexibel individualisierte Produkte entstehen lässt. Neben Szenarien wie Production-as-a-Service oder Predictive Maintenance werden auch neue intelligente Maschinen eingesetzt. Fahrerlose Transportsysteme planen ihre Fahrten eigenständig und passen diese an die Nachfrage an. Cobots unterstützen Fabrikarbeiter und können effizient für verschiedenste Arbeiten angelernt werden. Heutzutage werden Mechanismen wie Lichtschranken und Sicherheitskäfige benutzt, die das System völlig deaktivieren, sollte ein Mensch in die Schutzzone gelangen. Somit kann allerdings der gewünschte Grad der engen Interaktion mit dem Menschen nicht erreicht werden. Zukünftig bedarf es auch intelligenterer Schutzfunktionen bei der Benutzung von und der Interaktion mit solchen Systemen, damit ein Mensch keinem erhöhten Risiko ausgesetzt wird.

Digital Health

Schon heute werden Mediziner bei der Prävention, Diagnose und Therapie von Krankheiten durch KI-Systeme unterstützt. Die KI ist dabei oft für fortgeschrittene Bild- und Datenauswertung (z.B. bei der Interpretation eines CT-Bildes) zuständig. Sie erlaubt Analysen in Bezug auf Qualität und Quantität, die auf herkömmlichem Wege nicht zu erreichen sind. Selbst bei Operationen werden heute schon erste Robotersysteme eingesetzt, die jedoch vom Menschen kontrolliert werden. Doch je mehr sich ein Mediziner auf solche Systeme stützt und je höher zukünftig der Autonomiegrad eines KI-Systems wird, desto wichtiger wird die Beherrschung des Risikos eines Fehlers und eines Fehlverhaltens der KI.

Welche Rolle spielt Vertrauenswürdigkeit / Trustworthiness bei

Dependable AI?

Vertrauenswürdigkeit ist eine Voraussetzung für Menschen und Gesellschaften, um KI-Systeme zu entwickeln, einzusetzen und zu nutzen (Ethics Guidelines for Trustworthy AI der Europäischen Kommission). Ähnlich wie bei der Luftfahrt oder der Kernenergie sind es nicht nur die Komponenten des KI-Systems, die vertrauenswürdig sein müssen, sondern das sozio-technische System in seinem Gesamtkontext. Ein ganzheitlicher und systematischer Ansatz ist erforderlich, um die Vertrauenswürdigkeit sicherzustellen. Nach den Leitlinien der Europäischen Kommission besteht vertrauenswürdige KI aus drei Aspekten, die während des gesamten Lebenszyklus erfüllt sein sollten:

- Einhaltung der geltenden Gesetze und Vorschriften

- Einhaltung ethischer Grundsätze und Werte

- Robustheit aus technischer wie auch aus sozialer Sicht

Die Dependability des KI-Systems bezieht sich insbesondere auf den Aspekt der Robustheit des KI-Systems aus technischer Sicht unter Einhaltung der bestehenden Gesetze und Normen.

Was sind die Chancen für Unternehmen durch den Einsatz von Dependable AI?

Die Anwendungsfelder von KI im Allgemeinen sind vielfältig: In den Zukunftsszenarien fast aller Branchen spielt KI eine entscheidende Rolle – ob Smart Mobility, Smart Production/Industrie 4.0, Digital Health, Smart Farming, Smart City oder Smart Region. Die meisten Szenarien basieren darauf, dass datenbasierte intelligente Systeme angelernt werden, die aufgrund ihrer Komplexität nicht durch klassisches Programmieren konstruiert werden können. Mit Verfahren wie dem Maschinellem Lernen wird versucht, ein hoch komplexes Problem zu lösen, indem Modelle auf einer riesigen Menge von Daten erlernt werden.

KI-Ansätze können dabei dazu verwendet werden, entweder existierende Prozesse zu optimieren (wie effizientere Wartung von Maschinen oder Sortierung von Werkstücken) oder vollkommen neue nutzerorientierte Produkte und Dienste zu schaffen (wie intelligente Mobilitätsdienste auf Basis von autonomen Fahrzeugen).

Die Potenziale durch KI für die Wirtschaft wurden in verschiedensten Studien untersucht. Diese Studien sagen für die nächsten Jahre sowohl für Deutschland als auch weltweit ein starkes Wachstum vorher. Ein Großteil des Zuwachses wird durch völlig neue und stärker nutzerorientierte Produkte erwartet. Das Potenzial ist gewaltig, aber auch die Konkurrenz im globalen Wettbewerb ist groß. Länder wie die USA und China investieren in großem Maßstab und sind aufgrund ihrer Strukturen und ihrer Mentalität ein günstiges Umfeld für Start-ups und die schnelle Etablierung neuer innovativer Produkte und Services. Um sich im Wettbewerb zu behaupten, muss man sich in Europa und in Deutschland auf die eigenen Stärken besinnen: Ingenieurmäßig entwickelte Qualität und Verlässlichkeit!

Denn für viele der eingangs erwähnten Zukunftsszenarien ist Dependable AI entscheidend für den Erfolg. Dies betrifft zum Beispiel alles rund um hochautomatisierte bzw. Autonome Systeme und kognitive Systeme in sicherheitskritischen Anwendungsfeldern. Ohne Verlässlichkeit kein Vertrauen (Trust und Trustworthiness) und ohne Vertrauen keine Akzeptanz und kein Erfolg. Schließlich würde kaum jemand autonome Fahrzeuge nutzen oder mit lernfähigen Robotern im Arbeitsumfeld zusammenarbeiten, wenn diese nicht grundsätzlich sicher sind, was ihre Funktionsweise im dafür vorgesehenen Umfeld (wie im Straßenverkehr oder in der Fabrik) betrifft.

Wie können verlässliche KI-Systeme entwickelt werden?

Die Absicherung eines verlässlichen KI-Systems geschieht durch verschiedene Verfahren bei der Konstruktion, der Verifikation/Validation (V&V) und dem Betrieb in Abhängigkeit von der Kritikalität der Funktionalität.

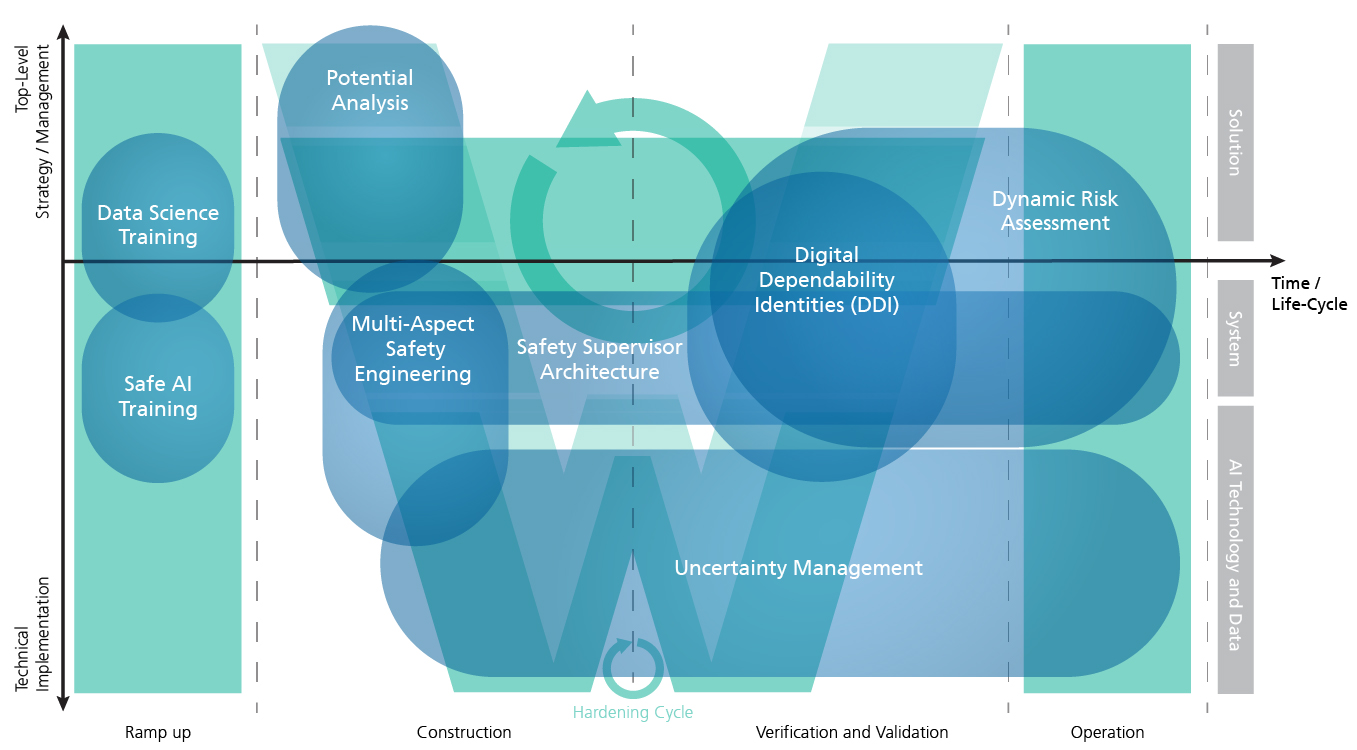

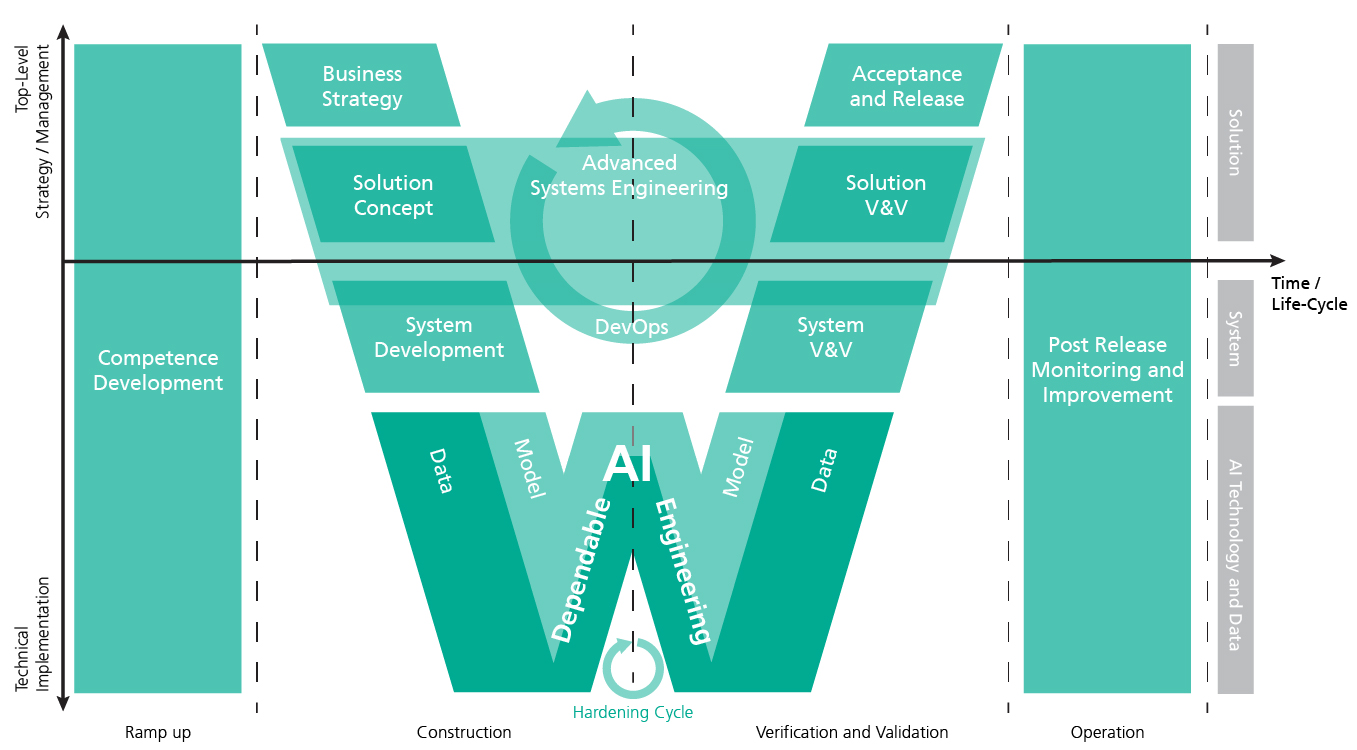

Abbildung 1 zeigt die Sicht des Fraunhofer IESE auf grundlegende Prozessbereiche in einem W-Modell. Dabei unterscheiden wir verschiedene Aktivitäten im Lebenszyklus eines KI-Systems (X-Achse) und verschiedene Stakeholder, die in den unterschiedlichen Phasen beteiligt sind: von der Managementebene bis hin zur operativen/technischen Ebene. Die Darstellung der Aktivitäten und Ebenen orientiert sich an der VDE-AR-E 2842-61, welche ein Referenzmodell für vertrauenswürdige KI definiert (entwickelt von der DKE, der in VDE und DIN zuständigen Organisation für die Erarbeitung von Normen). Grundsätzlich orientiert sich der Prozess an einem ganzheitlichen Systems-Engineering-Ansatz. Dabei ist es je nach Anwendungsfeld üblich, dass einzelne Systemkomponenten, die von Zulieferern als Blackbox geliefert werden, in das Gesamtsystem integriert werden müssen.

Kompetenzaufbau

Dem Entwicklungsprozess vorgeschaltet ist typischerweise eine Ramp-up-Phase, in welcher die im Unternehmen notwendigen Kompetenzen bestimmt und entwickelt werden. Für die Managementebene ist in diesem Zusammenhang wichtig, sowohl die konkreten Möglichkeiten von KI-Systemen für das eigene Geschäft zu verstehen als auch die Stolperfallen bei der Umsetzung. Für die operative/technische Ebene hingegen spielt das Wissen über konkrete Techniken/Methoden/Werkzeugen zur Realisierung eine wichtige Rolle.

Konstruktion und V&V

Der Gesamtprozess beginnt mit der Erstellung der Geschäftsstrategie und dem Herausarbeiten der konkreten Potenziale/Mehrwerte, die von einem KI-System erwartet werden. Daraus werden technische Anforderungen auf Systemebene und ein konkretes Lösungskonzept abgeleitet. In Abhängigkeit von der Kritikalität des Systems werden auf Systemebene weitere Analysen (z.B. bzgl. funktionaler Sicherheit) durchgeführt, um die regulatorischen und gesetzlichen Vorgaben bei der Entwicklung zu berücksichtigen. Das System wird im Rahmen klassischer Ansätze des Systems Engineerings (wie ISO/IEC 15288 oder 12207) in Teilsysteme zerlegt, die aus Software und Hardware bestehen können. Die Software-Teilsysteme wiederum bestehen aus klassischen Softwarekomponenten und solchen, die KI beinhalten und eine Normal- oder Sicherheitsfunktion des Systems abbilden. Softwarekomponenten werden heutzutage in einem agilen Entwicklungsprozess erstellt (wie z.B. Scrum), der parallel zur Entwicklung der Hardware erfolgt. Auch KI-Komponenten werden üblicherweise in einem hoch iterativen Prozess entwickelt, der sich aber eher an gängigen Vorgehen aus dem Bereich Data Science orientiert (wie CRISP-DM). Das bedeutet, dass das Modell inkrementell/iterativ solange verbessert wird, bis es die vorgegebenen Qualitätskriterien einhält. Man spricht in diesem Zusammenhang von der Evaluation bzw. Härtung des KI-Modells. Anschließend werden die Einzelkomponenten des Systems zum Gesamtsystem integriert und als Ganzes verifiziert bzw. validiert, bevor das System nach Durchlauf definierter Akzeptanz- und Release-Kriterien nach außen gegeben werden kann (z.B. nach geforderten Testing- und Auditing-Prozessen). In der Praxis wird dieser Gesamtprozess zur Konstruktion und Verifikation/Validation je nach Größe und Komplexität des Systems und des Entwicklungsprojekts auch mehrfach in Iterationen durchlaufen.

Betrieb

Der Lebenszyklus eines KI-Systems endet nicht mit der Bereitstellung des Systems. In der Betriebs-/Operation-Phase geht es darum, die Performanz des Systems zu überwachen und aus dem tatsächlichen Verhalten zu lernen, wie das KI-System bzw. KI-Modell verbessert werden kann. Bei KI-Systemen, die zur Laufzeit weiterlernen, also ihr Verhalten auf Basis der gemachten Erfahrungen verändern, sind zudem weitere Verfahren des dynamischen Risikomanagements notwendig.

Wie kann das Fraunhofer IESE mein Unternehmen bei Dependable AI konkret unterstützen?

Grundsätzlich berät und unterstützt das Fraunhofer IESE Unternehmen ganzheitlich beim Engineering verlässlicher KI-Systeme und begleitet sie über den gesamten Lebenszyklus: von der KI-Strategie über die KI-Entwicklung bis zur KI-Absicherung bzw. zum KI-Testing/Auditing und zur Erfüllung der gesetzlichen und normativen Vorgaben. Wir sind dabei multidisziplinär aufgestellt, d.h., wir verfügen über Kompetenzen sowohl im Bereich Software- und Systems-Engineering als auch in Data Science und Innovationsstrategie.

Aus unserer Forschung im Kontext Dependable AI haben wir konkrete Lösungsbausteine für wesentliche Herausforderungen entwickelt, die wir in die Praxis übertragen. Abbildung 2 zeigt eine Einordnung von Lösungsbausteinen in die dargestellten Prozessbereiche des W-Modells.

KI-Potenzialanalyse

Im Rahmen von Potenzialanalysen wird der Mehrwert von KI für ein Unternehmen herausgearbeitet. Mit etablierten Vorlagen (wie Value Proposition oder BMC) werden die Auswirkungen von KI auf das Geschäftsmodell ausgearbeitet. Wir stellen für einen Anwendungskontext relevante Normen, Standards und Qualitätsrichtlinien zusammen und zeigen auf, welche KI-Systeme heute schon möglich sind und welche Vorgaben man in Zukunft in Abhängigkeit von der Kritikalität einhalten muss. Dabei wird auch die Lücke zwischen der aktuellen Aufstellung des Unternehmens und der zukünftigen Ausrichtung ermittelt und eine Strategie erarbeitet. Im Rahmen von Prototypen werden vielversprechende Anwendungsszenarien in Bezug auf Profitabilität, Nachfrage und technische Umsetzbarkeit evaluiert (z.B. im Hinblick auf die Verfügbarkeit von Daten und die Güte der Vorhersage).

Multi-Aspect Safety Engineering

Insbesondere für die Entwicklung von hochautomatisierten und Autonomen Systemen spielt nicht nur die funktionale Sicherheit (ISO 26262), sondern auch die Sicherheit der beabsichtigten Funktionalität (SOTIF, ISO/PAS 21448) und die systematische Entwicklung eines sicheren Nennverhaltens eine wichtige Rolle. In einem modellbasierten Ansatz nutzen wir moderne Methoden und Techniken des Safety Engineerings, um das System ganzheitlich zu modellieren, zu analysieren und die gefundenen Risiken zu beherrschen. Die Argumentation, dass das System verlässlich ist, erfolgt dabei über Assurance- oder Safety-Case-Analysen. Über Evidenzen wird argumentiert, dass sich das System bzgl. des Assurance bzw. Safety Cases entsprechend so verhält, dass die Risikoakzeptanzschwelle nicht überschritten wird.

Safety-Supervisor-Architektur

Ein weiteres zentrales Element für die Verlässlichkeit des Systems stellt die Systemarchitektur dar. Hier gibt es z.B. Architekturen, die eine Art Sicherheitscontainer um die KI legen. Diese Safety-Supervisor- oder Simplex-Architekturen überschreiben die KI-Entscheidung, falls diese zu einem gefährlichen Verhalten des KI-Systems führen würde. Dazu ist es wichtig, z.B. die Unsicherheit der KI-Empfehlung unter bestimmten Nutzungsbedingungen zu kennen und darauf basierend das Risiko einer fehlerhaften Entscheidung zu ermitteln. Solche Ansätze sind für Machine-Learning-Komponenten im Allgemeinen interessant und besonders wichtig, wenn es sich um KI-Systeme handelt, die über ihre Lebenszeit hinweg weiter lernen und daher ihr Verhalten anpassen können. Da es potenziell unmöglich ist, zum Entwurfszeitpunkt eines KI-Systems zu wissen, welche Daten die KI als Grundlage für weiteres Lernen verwendet, müssen entsprechende Leitplanken für das Verhalten definiert und in das System eingebaut werden.

Digital Dependability Identities (DDI)

Eine Digital Dependability Identity (DDI) ist ein Instrument, um zentral alle Spezifikationen, die für die Systemverlässlichkeit relevant sind, einheitlich und austauschbar zu dokumentieren und diese Spezifikation mit einem System bzw. Systemteil auszuliefern. Dies ist insbesondere dann wichtig, wenn Systemteile unterschiedlicher Hersteller/Zulieferer entlang der Lieferkette integriert werden müssen bzw. falls eine dynamische Integration verschiedener Systemteile zur Laufzeit erfolgt (wie beim kollaborativen Fahren). Das Rückgrat der DDI ist ein Assurance Case, der alle Spezifikationen strukturiert und miteinander verknüpft und so argumentiert, unter welchen Bedingungen das System verlässlich arbeitet. Die Art der Evidenzen in der Argumentationskette ist ganz unterschiedlich. Sie können die Sicherheitsarchitektur betreffen oder das Management von Unsicherheiten der KI-Komponente, beispielsweise den Nachweis, dass man Daten verwendet, welche den intendierten Verwendungskontext ausreichend abdecken.

Dynamic Risk Management (DRM)

DRM ist ein Ansatz zur kontinuierlichen Überwachung des Risikos eines Systems und seines geplanten Verhaltens sowie seiner sicherheitsrelevanten Fähigkeiten. DRM überwacht das Risiko, optimiert die Leistung und gewährleistet die funktionale Sicherheit durch ein kontinuierliches Management, das sich auf Laufzeitmodelle stützt. Ein Bestandteil des DRM von KI-basierten Systemen kann auch die Ausgabe eines Uncertainty Wrappers sein.

Uncertainty Management

Unsicherheit ist bei datenbasierten Lösungen ein inhärentes Problem und kann nicht ignoriert werden. Der Uncertainty Wrapper ist ein ganzheitlicher, modellunabhängiger Ansatz zur Identifizierung situativ zuverlässiger Prognosen von Unsicherheiten in KI-Komponenten. Diese Unsicherheiten können neben dem KI-Modell selbst auch aus den Eingabedaten und dem Verwendungskontext kommen. Der Uncertainty Wrapper kann einerseits bei der Entwicklung des KI-Modells eingesetzt werden, um die identifizierten Unsicherheiten durch entsprechende Maßnahmen zu beherrschen und das Modell sicherer zu gestalten. Andererseits ermöglicht der Wrapper zur Laufzeit des KI-Systems eine ganzheitliche Betrachtung der aktuellen Unsicherheit der KI-Komponente. Diese Einschätzung kann wiederum von einem Sicherheitscontainer verwendet werden, um die KI zu übersteuern und das System in einen risikoärmeren Zustand zu überführen.

Trainings

Nicht zuletzt sind wir auch in der Qualifizierung entsprechender Kompetenzen im Unternehmen aktiv: von Enlightening Talks für das Management über Weiterbildungsprogramme zum Data Scientist bis hin zu Spezialschulungen für verlässliche KI-Systeme (z.B. Safe-AI-Schulung).

Warum sollte mein Unternehmen für Dependable AI mit dem Fraunhofer IESE zusammenarbeiten?

Künstliche Intelligenz (KI) und Maschinelles Lernen (ML) haben großes Potenzial, bestehende Produkte und Dienste zu verbessern – oder gar völlig neue Produkte und Dienste zu ermöglichen. Allerdings stellt die Gewährleistung und Überprüfung wesentlicher Qualitätseigenschaften von KI-Systemen, und dabei insbesondere von Eigenschaften der Verlässlichkeit, eine große Herausforderung dar. Wer hier adäquate Lösungen findet und umsetzt, hat klare Wettbewerbsvorteile! Wir sind überzeugt: Mit unseren Methoden und Lösungsbausteinen können wir Sie auf diesem Weg tatkräftig und effektiv unterstützen!

Das Fraunhofer IESE berät und unterstützt Unternehmen ganzheitlich beim Engineering verlässlicher KI-Systeme:

Ende-zu-Ende: Wir begleiten Unternehmen über den gesamten Lebenszyklus: von der KI-Strategie über die KI-Entwicklung bis zur KI-Absicherung bzw. zum KI-Testing/Auditing und zur Erfüllung der gesetzlichen und normativen Vorgaben.

Multidisziplinär: Wir sind multidisziplinär aufgestellt, d.h., wir verfügen über Kompetenzen sowohl im Bereich Software- und Systems-Engineering als auch in Data Science und Innovationsstrategie. Entsprechend bieten wir eine zentrale Anlaufstelle, in der alle relevanten Kompetenzen rund um Dependable AI vorhanden sind.

Innovativ: Als Fraunhofer-Institut sind wir in innovativen Forschungsprojekten für Dependable AI auf Bundes- und EU-Ebene vertreten, sodass wir den aktuellen Stand der Forschung und Praxis in Bezug Prozesse, Technologien und Werkzeuge für Dependable AI kennen.

Informiert: Wir sind über Verbände und Normungsgremien in Roadmap- und Normungsaktivitäten zu Dependable AI involviert, sodass wir Zugriff auf aktuelle Diskussionen haben und zukünftige Änderungen der gesetzlichen und normativen Vorgaben kennen.

Aus einer Hand: Als Mitglied der Fraunhofer-Allianz Big Data und Künstliche Intelligenz (KI) haben wir Zugriff auf umfängliche Ressourcen (Data Scientists, Softwarepakete und Recheninfrastruktur). Dadurch können wir auch komplexere Projekte im Kontext Dependable AI aus einer Hand anbieten.

Unser Beitrag für die erfolgreiche Umsetzung von Dependable AI

KI-Potenzialanalyse

Wir unterstützen Unternehmen darin, Potenziale und Risiken von KI-Systemen in kritischen Anwendungsfällen zu identifizieren und Prototypen zu erstellen. Damit können Fehlinvestitionen und Opportunitätskosten vermieden werden.

Multi-Aspect Safety Engineering

Wir erarbeiten Sicherheitsargumente für sicherheitskritische KI-Systeme unter Berücksichtigung geltender und in Entwicklung befindlicher Vorgaben. Damit ist die Sicherheitsargumentation auf der Basis des aktuellen Stands der Forschung und Praxis zukunftssicher.

Safety-Supervisor-Architektur

Wir entwickeln KI-Architekturen, die Risiken möglichst frühzeitig abfangen und zu einem verlässlichen KI-System führen. Damit können innovative KI-basierte Lösungen auch in sicherheitskritischen Anwendungsfällen zum Einsatz kommen.

Digital Dependability Identities (DDI)

Wir spezifizieren, unter welchen Bedingungen eine kritische Komponente verlässlich ist und integrieren dies in die Sicherheitsargumentation des Systems. Damit können kritische Systemteile unterschiedlicher Hersteller/Zulieferer integriert und sogar zur Laufzeit dynamisch kombiniert werden.

Dynamic Risk Management (DRM)

Wir entwickeln Mechanismen, um das Risiko kritischer KI-Systeme dynamisch zur Laufzeit zu überwachen und gezielt potenzielle Gefährdungen zu reduzieren. Dies erlaubt eine effiziente und effektive Interaktion mit dem KI-System und auch die Beherrschung des Risikos bei selbstlernenden KI-Systemen.

Uncertainty Management

Wir stellen Softwarelösungen für das Management von Unsicherheiten einer KI-Komponente zur Verfügung. Damit können Unsicherheiten zur Entwicklung und Laufzeit identifiziert und beherrschbar gemacht werden.

Trainings

Wir identifizieren im Unternehmen Wissenslücken in Bezug auf Dependable AI und entwickeln Strategien für den Aufbau der erforderlichen Kompetenzen. Damit können notwendige KI-Kompetenzen auf allen Ebenen des Unternehmens nachhaltig aufgebaut werden und die Innovationsfähigkeit wird gestärkt.

Publikationen aus dem Bereich Dependable AI

Veröffentlichungen des Fraunhofer IESE im Themenumfeld »Dependable AI«

Model-based Safety Engineering

- Feth, P., Adler, R., Fukuda, T., Ishigooka, T., Otsuka, S., Schneider, D., ... & Yoshimura, K. (2018, September). „Multi-aspect safety engineering for highly automated driving“. In International Conference on Computer Safety, Reliability, and Security (pp. 59-72). Springer, Cham.

- Domis, Dominik. „Integrating fault tree analysis and component-oriented model-based design of embedded systems“, Verlag Dr. Hut, 2012.

- Kaiser, B., Liggesmeyer, P., & Mäckel, O. (2003, October). „A new component concept for fault trees“. In Proceedings of the 8th Australian workshop on Safety critical systems and software-Volume 33 (pp. 37-46).

- Kaiser, B., Schneider, D., Adler, R., Domis, D., Möhrle, F., Berres, A., ... & Rothfelder, M. (2018, June). „Advances in component fault trees“. In Proceedings of the 28th European Safety and Reliability Conference (ESREL).

- Reich, J, et al. Herausforderungen und Lösungsansätze für die durchgängige Freigabeargumentation von automatisierten Fahrfunktionen: Erste Ergebnisse aus dem BMWi "V&V Methoden"-Projekt

- Kläs, M., Adler, R., Jöckel, L., Gross, J., Reich, J., "Using Complementary Risk Acceptance Criteria to Structure Assurance Cases for Safety-Critical AI Components", AI Safety 2021 at International Joint Conference on Artificial Intelligence (IJCAI), Montreal, Canada, 2020.

- Kläs, M., Adler, R., Heidrich, J., “Testen im Zeitalter von KI”, Informatik Aktuell, 2020

Hardening of ML Models – AI and Data Engineering

- Adler, R., et al., “Hardening of Artificial Neural Networks for Use in Safety-Critical Applications - A Mapping Study”, https://arxiv.org/abs/1909.03036, 2019.

- Kläs, M., “Towards Identifying and Managing Sources of Uncertainty in AI and Machine Learning Models - An Overview,” https://arxiv.org/abs/1811.11669, 2018.

- Kläs, M., Vollmer, A. M., "Uncertainty in Machine Learning Applications – A Practice-Driven Classification of Uncertainty," First International Workshop on Artificial Intelligence Safety Engineering (WAISE 2018), Västerås, Sweden, 2018.

- Mohammed Naveed Akram, Pascal Gerber and Daniel Schneider, “Hardening of CNN-LSTM powered by Explainable AI techniques”. Submitted to the safecomp WAISE Workshop 2021.

- Jöckel, L., Kläs, M., "Increasing Trust in Data-Driven Model Validation - A Framework for Probabilistic Augmentation of Images and Meta-Data Generation using Application Scope Characteristics", International Conference on Computer Safety, Reliability and Security (SAFECOMP 2019), Turku, Finland, 2019.

- Jöckel, L., Kläs, M., Martínez-Fernández, S., "Safe Traffic Sign Recognition through Data Augmentation for Autonomous Vehicles Software“, 19th IEEE International Conference on Software Quality, Reliability and Security Companion (QRS-C), Sofia, Bulgaria, 2019.

Operation – Systematic Engineering of Runtime Safety Assurance

- Kläs, M., Adler, R., Sorokos, I., et al., “Handling Uncertainties of Data-Driven Models in Compliance with Safety Constraints for Autonomous Behaviour”, European Dependable Computing Conference (EDCC 2021), 2021

- Trapp, Mario; Schneider, Daniel; Weiss, Gereon (2018): Towards Safety-Awareness and Dynamic Safety Management. In : 2018 14th European Dependable Computing Conference (EDCC). Iasi, pp. 107–111.

Schneider, Daniel; Trapp, Mario (2018): B-space: dynamic management and assurance of open systems of systems. In J Internet Serv Appl 9 (1). DOI: 10.1186/s13174-018-0084-5. - Dynamic Risk Management Overview Videos/Webinars:

o https://www.youtube.com/watch?v=uyxCIViOb40 (German, 2020)

o https://www.youtube.com/watch?v=HY9NrJHLxRI (English, 2020)

o https://www.youtube.com/watch?v=Vdn-TCGxzgA (Platooning Demonstration)

- ·Schneider, Daniel; Trapp, Mario (2013): Conditional Safety Certification of Open Adaptive Systems. In ACM Trans. Auton. Adapt. Syst. 8 (2), pp. 1–20. DOI: 10.1145/2491465.2491467.

Kabir, Sohag, et al. "A runtime safety analysis concept for open adaptive systems". International Symposium on Model-Based Safety and Assessment. Springer, Cham, 2019. - Reich, Jan, et al. "Engineering of Runtime Safety Monitors for Cyber-Physical Systems with Digital Dependability Identities". International Conference on Computer Safety, Reliability, and Security. Springer, Cham, 2020.

- Feth, Patrik (2020): Dynamic Behavior Risk Assessment for Autonomous Systems. Dissertation. Technical University Kaiserslautern, Germany.

- Reich, Jan, and Mario Trapp. "SINADRA: Towards a Framework for Assurable Situation-Aware Dynamic Risk Assessment of Autonomous Vehicles". 2020 16th European Dependable Computing Conference (EDCC). IEEE, 2020.

- Reich, Jan, et al. “Towards a Software Component to Perform Situation-Aware Dynamic Risk Assessment for Autonomous Vehicles”. Submitted to DREAMS Workshop (Dynamic Risk Management for Autonomous Systems) co-located with European Dependable Computing Conference 2021.

- Kläs, M., Sembach, L., "Uncertainty Wrappers for Data-driven Models - Increase the Transparency of AI/ML-based Models through Enrichment with Dependable Situation-aware Uncertainty Estimates," Second International Workshop on Artificial Intelligence Safety Engineering (WAISE 2019), Turku, Finland, 2019.

- Kläs, M., Jöckel, L., "A Framework for Building Uncertainty Wrappers for AI/ML-based Data-Driven Components," Third International Workshop on Artificial Intelligence Safety Engineering (WAISE 2020), Lisbon, Portugal, 2020.

- Jöckel, L., Kläs, M., "Could We Release AI/ML Models from the Responsibility of Providing Dependable Uncertainty Estimates? - A Study on Outside-Model Uncertainty Estimates," International Conference on Computer Safety, Reliability and Security (SAFECOMP 2021), 2021.

- Aslansefat, Koorosh, Ioannis Sorokos, Declan Whiting, Ramin Tavakoli Kolagari, and Yiannis Papadopoulos. "SafeML: Safety Monitoring of Machine Learning Classifiers Through Statistical Difference Measures", In International Symposium on Model-Based Safety and Assessment, pp. 197-211. Springer, Cham, 2020.