Im Rahmen unserer Blogreihe »Scope Compliance« beschäftigen wir uns mit der Bedeutung des Anwendungskontexts im Machine Learning. Im ersten Beitrag klären wir ein häufig anzutreffendes Missverständnis auf und arbeiten seine Implikationen für die Praxis heraus. Sie erfahren, warum es entscheidend ist zu erkennen, wenn ein Modell außerhalb seines Anwendungskontexts eingesetzt wird, und wie sich die daraus resultierenden praktischen Problemstellungen systematisieren lassen. In den kommenden Beiträgen stellen wir Ihnen dann sukzessive Ansätze vor, um diese Probleme anzugehen und damit die Vertrauenswürdigkeit Ihrer datenbasierten Modelle zu erhöhen.

Die Grenzen des »Lernens« bei datengetriebenen Modellen

»Maschinelles Lernen«: Diesen Begriff hat wohl jede*r von uns schon einmal gehört. Er verspricht unserer Gesellschaft Großes, weckt Erwartungen und führt damit häufig auch zu Missverständnissen. Ein häufiges Missverständnis im Kontext von Machine Learning besteht beispielsweise darin, dass davon ausgegangen wird, dass Modelle, die auf maschinellem Lernen basieren, sogenannte datengetriebene Modelle, auch bei neuartigen Umgebungen und/oder Situationen wie gewohnt verlässliche Ergebnisse liefern können.

Diesem Missverständnis liegt eine unzureichende Differenzierung dessen zugrunde, was »Lernen« im Kontext datengetriebener Modelle aktuell tatsächlich bedeutet und folglich leisten kann. »Lernen« meint in diesem Zusammenhang nämlich, dass auf Grundlage einer geeigneten Auswahl von Fallbeispielen in Form von Datenpunkten ein Konzept oder Zusammenhang generalisiert werden kann. Das bedeutet, dass das Modell nicht die Datenpunkte selbst memoriert, sondern von diesen abstrahiert. Ein Modell zur Verkehrsschilderkennung merkt sich z.B. nicht die Pixelkombination aller möglichen Bilder, die ein Vorfahrtsschild zeigen, sondern extrahiert die Gemeinsamkeiten, die diesen Bildern zugrunde liegen. Das erlernte Konzept bzw. der Zusammenhang kann dann auf neue Datenpunkte angewandt werden.

Ob das Modell bei der Anwendung im Endeffekt gute Ergebnisse liefert, hängt also einerseits davon ab, ob das Modell ein geeignetes Konzept erlernt hat, und anderseits davon, ob das Konzept im Kontext der neuen Daten auch anwendbar ist.

Erlernen geeigneter Konzepte

Wenn ein Modell beispielsweise gelernt hat, ein Wildwechsel-Verkehrsschild von einem Fußgänger-Verkehrsschild anhand der umgebenden Landschaft im Bildhintergrund (z.B. ländlich versus urban) und nicht anhand der dort abgebildeten Piktogramme zu unterscheiden, dann hat das Modell recht offensichtlich ein eher ungeeignetes Konzept erlernt. Solche Probleme lassen sich jedoch zumindest in Teilen mittels Tests und eXplainable AI (XAI)-Techniken aufdecken und mittels passender Trainingsdaten adressieren.

Weitergehend lässt sich gewöhnlich eine statistisch begründete Aussage über die Zuverlässigkeit des Modells ableiten, wenn dieses auf einem für die geplante Anwendung repräsentativen Testdatensatz geprüft wurde. Diese Zuverlässigkeit gilt dann für zufällige – dem Modell unbekannte – Datenpunkte aus dem geplanten Anwendungskontext. Bestimmt wird beim Testen folglich die Generalisierungsfähigkeit des Modells im geplanten Anwendungskontext.

Anwendbarkeit erlernter Konzepte

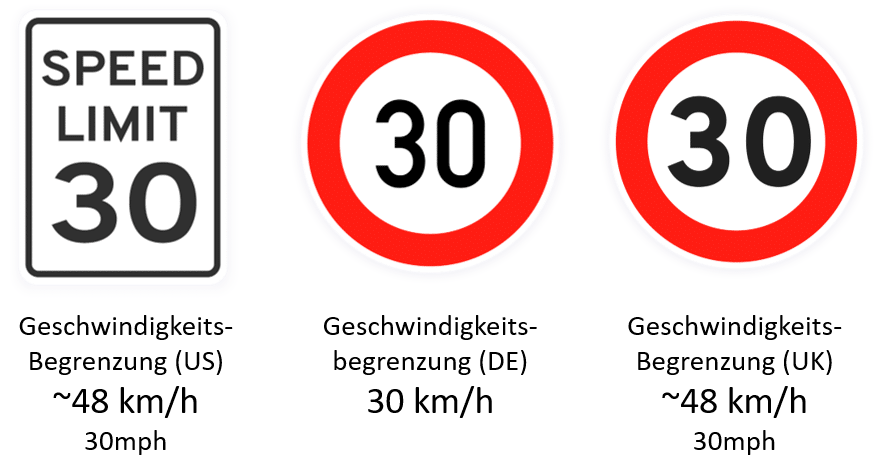

Was aber, wenn ein Modell auf Datenpunkte angewendet wird, die nicht dem geplanten und damit hoffentlich auch in der Prüfung berücksichtigten Anwendungskontext entstammen? Welche Zuverlässigkeit können wir berechtigterweise erwarten, wenn eine auf einem deutschen Testdatensatz geprüfte Verkehrszeichenerkennung bei einer Fahrt in England oder den Vereinigten Staaten zum Einsatz kommt? Die Antwort lautet: KEINE!

Man könnte evtl. damit argumentieren, dass sich gewisse Schilder in ihrem Aussehen über Ländergrenzen hinweg ähneln und dass eine Geschwindigkeitsbegrenzung in den USA zwar nicht korrekt vom Modell als solche identifiziert werden kann, das Modell diese aber zumindest als ein unbekanntes Schild klassifizieren könnte. Das ist im Übrigen gar nicht so trivial und wird bei aktuellen Modellen eher selten umgesetzt.

Spätestens jedoch bei der englischen Geschwindigkeitsbegrenzung ist das Modell offensichtlich chancenlos. Da es auf Basis deutscher Daten trainiert wurde, kann das Modell im Voraus nicht gelernt haben, dass die gleiche Ziffernfolge auf einem vergleichbaren Schild in diesem Fall nicht Kilometer, sondern Meilen pro Stunde angibt. Wir haben es also semantisch mit einem anderen Schild zu tun. Eine Generalisierungsfähigkeit eines Modells über den geplanten Anwendungskontext hinaus lässt sich damit also nicht sicherstellen, geschweige denn nachweisen. Tatsächlich ist es sogar so, dass insbesondere aktuelle Methoden des maschinellen Lernens mit ihrer hohen Flexibilität und ihren gigantischen Hypothesenräumen zu Modellen führen, die äußerst fragil auf Veränderungen im Anwendungskontext reagieren.

Was bedeutet das für das Machine Learning in der Praxis?

Die Tatsache, dass nicht immer organisatorisch sichergestellt werden kann, dass Machine-Learning-basierte Modelle wirklich nur in dem Anwendungskontext verwendet werden, für den sie tatsächlich entwickelt und getestet wurden, stellt uns somit vor eine Herausforderung. Zudem können im Anwendungskontext auch schleichend Veränderungen entstehen. Nahezu alle beobachtbaren Prozesse unterliegen im Laufe der Zeit gewissen Veränderungen. So ändert sich auch in Deutschland nicht nur die Häufigkeit der anzutreffenden Verkehrsschildtypen, sondern es kommen auch regelmäßig neue Typen hinzu. Existierende werden zudem häufig angepasst oder ausgemustert [BMVI].

Um also valide Zuverlässigkeitszusagen machen zu können, gilt es für uns daher festzustellen, wann ein Modell kurzfristig mit einer Situation konfrontiert ist, für die es nicht entwickelt wurde (z. B. bei Konfrontation mit einem neuen oder verunstalteten Verkehrsschild) oder wo sich der Anwendungskontext nachhaltig zu stark geändert hat. Dazu muss die sogenannte »Scope Compliance« während der Modellanwendung beispielsweise mit einem »Uncertainty Wrapper« überwacht werden.

Scope Compliance bedeutet die Wahrscheinlichkeit, dass sich ein datengetriebenes Modell in der aktuellen Anwendungssituation innerhalb seines intendierten Anwendungskontexts bewegt. [1]

Uncertainty Wrappers sind ein modell-agnostisches Konzept, um datengetriebene Modelle um eine Unsicherheitsprognose zu erweitern, die unterschiedliche Quellen von Unsicherheiten, wie sie im Zwiebelschalenmodell ausgearbeitet wurden, berücksichtigt [2]. Hierzu zählt insbesondere auch Unsicherheit aufgrund fehlender Scope Compliance [1].

Um zu verstehen, wie eine solche Überwachung überhaupt realisiert werden kann und was hierbei überwacht werden sollte, muss zunächst einmal verstanden werden, was einen Anwendungskontext aus Sicht eines datengetriebenen Modells überhaupt ausmacht und welche Arten von Veränderungen dabei zu unterscheiden sind. Dabei kann man zudem die wichtigsten Begrifflichkeiten in diesem Zusammenhang kennen lernen.

Was charakterisiert den Anwendungskontext aus Sicht eines Modells?

Leider geht es hier nicht ganz ohne ein wenig Mathematik – aber wirklich nur ein wenig. Nehmen wir an, die Eingabe eines Modells sei durch x gegeben und die erwartete Ausgabe durch y. Hierbei könnte x das Bild eines Verkehrsschilds sein und y der durch das Modell identifizierte Verkehrsschildtyp, also z.B. »Zulässige Höchstgeschwindigkeit 30 km/h«.

Nun charakterisiert sich der Anwendungskontext für das Modell durch die gemeinsame Wahrscheinlichkeitsverteilung über alle möglichen Eingaben und die entsprechend erwarteten Ausgaben in diesem Kontext, kurz P(X,Y). Die Verteilung P bestimmt dabei sowohl, wie häufig eine bestimmte Eingabe x im Anwendungskontext zu erwarten ist, als auch, welches die entsprechend korrekte/intendierte Ausgabe wäre.

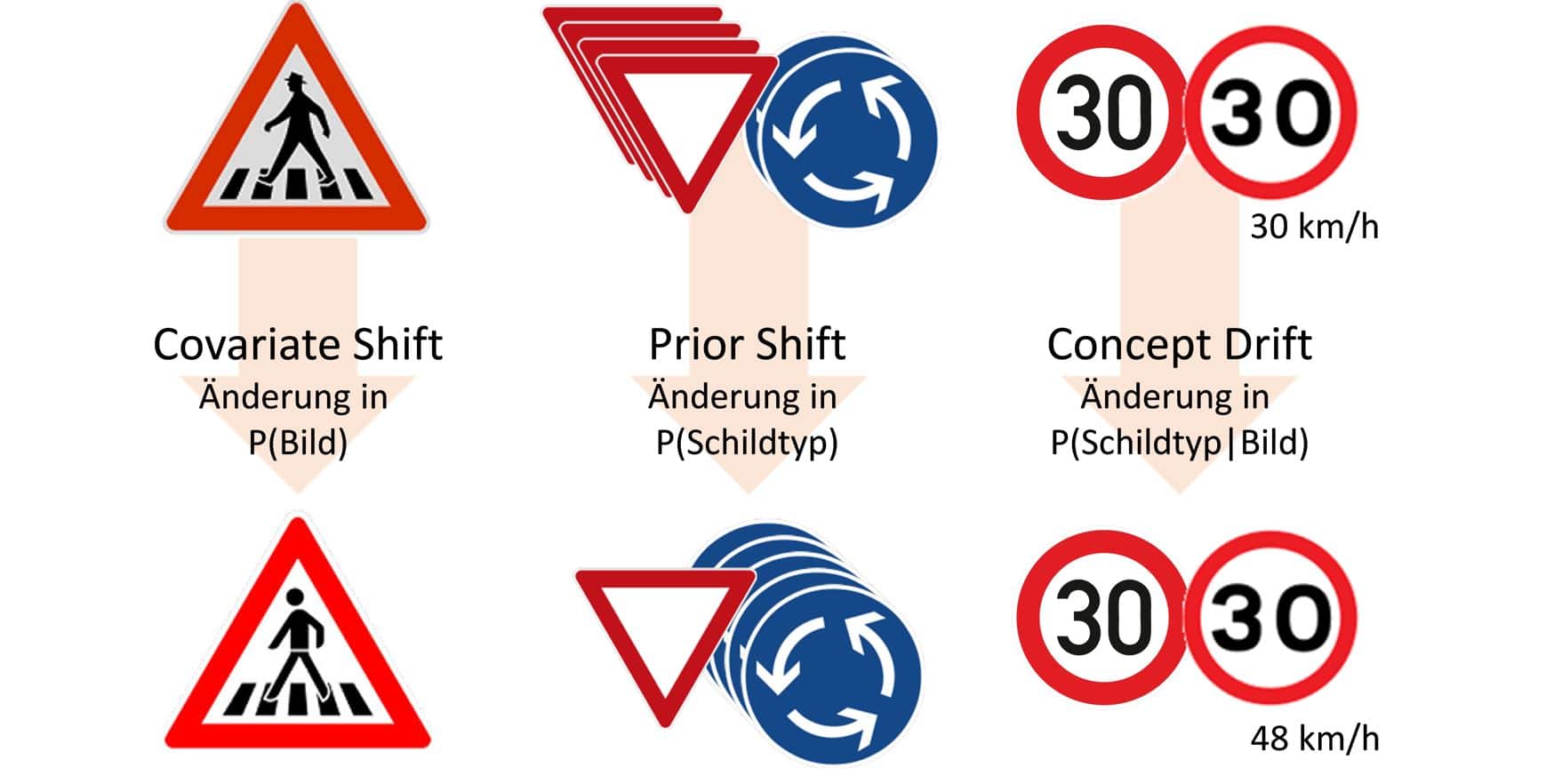

Mathematisch gesehen sind Änderungen des Anwendungskontexts aus Modellsicht folglich Änderungen in genau der genannten Verteilung P(X,Y). Bei solchen Veränderungen redet man dann ganz allgemein vom »Domain Shift«. Dabei lassen sich drei grundsätzlich unterschiedliche Arten eines »Domain Shifts« voneinander unterscheiden, die wir im Folgenden am Beispiel der Verkehrsschilderkennung aufzeigen.

Covariate Shift

Bei der Erkennung von Verkehrsschildern wird von dem Bild x auf den Verkehrsschildtyp geschlossen. Die entsprechende Zufallsvariable X, mit der Verteilung P(X) wird daher als unabhängige Variable, engl. covariate, bezeichnet. Ein »Covariate Shift« liegt vor, wenn sich diese Verteilung P(X) ändert. Dies wäre beispielweise der Fall, wenn es im Anwendungskontext bisher nicht geschneit hat, nun aber Verkehrsschilder aufgrund eines Schneesturms teilweise schneebedeckt sind oder im Rahmen einer Modernisierung das Erscheinungsbild eines Verkehrsschildtyps angepasst wird.

Prior Shift

Die A-priori-Verteilung oder englisch prior distribution P(Y) gibt die grundsätzlichen Wahrscheinlichkeiten für das Auftreten eines bestimmten Ergebnisses, in unserem Fall also eines bestimmten Verkehrsschildtypen, im Anwendungskontext an. Die aktuelle Fahrsituation und die Modelleingabe x wie z.B. das Kamerabild werden hierbei außer Acht gelassen. Ein »Prior Shift« äußert sich in einer Veränderung der relativen Häufigkeiten, mit denen die verschiedenen Verkehrsschildtypen im Anwendungskontext vorkommen. Beispielsweise könnte sich durch eine stärkere Urbanisierung oder geänderte Verkehrspolitik die Häufigkeit einzelner Schildertypen (z.B. »Kreisverkehr«) in Relation zu anderen Typen ändern.

Concept Drift

Die bedingte Wahrscheinlichkeitsverteilung P(Y|X) beschreibt die Wahrscheinlichkeiten, dass gegebenen Eingaben bestimmte Ausgaben zugeordnet werden – in unserem Beispiel also, dass ein konkretes Bild x einen bestimmten Typ y von Verkehrsschild darstellt. Sie beschreibt also das Konzept, nach dem die Pixelwerte des Bildes mit dem Verkehrsschildtyp verbunden sind. Ein »Concept Drift« entsteht, wenn sich die Art, wie Bilder den Verkehrsschildtypen zugeordnet sind, ändert. Ein Beispiel dafür ist die unterschiedliche Bedeutung der Geschwindigkeitsbegrenzungsschilder zwischen Großbritannien und Deutschland. Nahezu identisch aussehende Schilder haben abhängig vom Anwendungskontext eine andere Bedeutung. Die gleichen Bilder müssen also abhängig vom Anwendungskontext verschiedenen Klassen zugeordnet werden und folglich muss auch die bedingte Wahrscheinlichkeitsverteilung P(Y|X) angepasst werden.

Fazit und Ausblick

Die in diesem Artikel genannten Beispiele illustrieren, dass die Güte der Ergebnisse eines auf Machine Learning basierenden Modells nicht nur vom Modell selbst, sondern auch vom Anwendungskontext abhängt. Änderungen im Anwendungskontext können unterschiedlichste Gründe haben und zu Covariate Shifts, Prior Shifts und Concept Drifts führen. In jedem Fall müssen solche Änderungen in der Anwendung rechtzeitig erkannt und geeignet behandelt werden, um eine zuverlässige Verwendung des Modells sicherzustellen. Wie dies in der Praxis umsetzbar ist, erfahren Sie in einem unserer nächsten Blog-Beiträge oder gerne auch in einem persönlichen Gespräch.

Lesen Sie auch unsere weiteren Artikel zum Thema Scope Compliance:

- Teil 1: Scope Compliance – die Rolle des Anwendungskontexts im Machine Learning

- Teil 2: folgt

- Teil 3: folgt

Sie haben noch weitere Fragen zu Machine Learning, insbesondere bezüglich der Themen Anwendungskontext und Scope Compliance, oder möchten sich gerne mit unseren Expert*innen austauschen? – Dann kontaktieren Sie uns gerne per Mail.

_______________________________________________________________

Nutzen Sie außerdem auch gerne unser Weiterbildungsangebot!

In unserer 4-tägigen Weiterbildung zum zertifizierten »Data Scientist Specialized in Assuring Safety« lernen Sie u. a. wie die Absicherung von KI in sicherheitskritischen Systemen gelingen kann.

Literatur

[1] Kläs, M., Vollmer, A. M., „Uncertainty in Machine Learning Applications: A Practice-Driven Classification of Uncertainty,“ First International Workshop on Artificial Intelligence Safety Engineering (WAISE 2018), Västerås, Sweden, 2018.

[2] Kläs, M., Sembach, L., „Uncertainty Wrappers for Data-driven Models – Increase the Transparency of AI/ML-based Models through Enrichment with Dependable Situation-aware Uncertainty Estimates,“ Second International Workshop on Artificial Intelligence Safety Engineering (WAISE 2019), Turku, Finland, 2019.