Der wesentliche Unterschied zwischen ingenieurmäßigen und datengetriebenen Lösungen ist, aus eigener Erfahrung, Betroffenen häufig nicht explizit im Bewusstsein. Vielleicht, weil Ingenieure eher selten maschinelle Lernverfahren einsetzen und die Spezialisten für maschinelles Lernen häufig keine Ingenieure sind.

Intelligente Produkte – aber sicher?

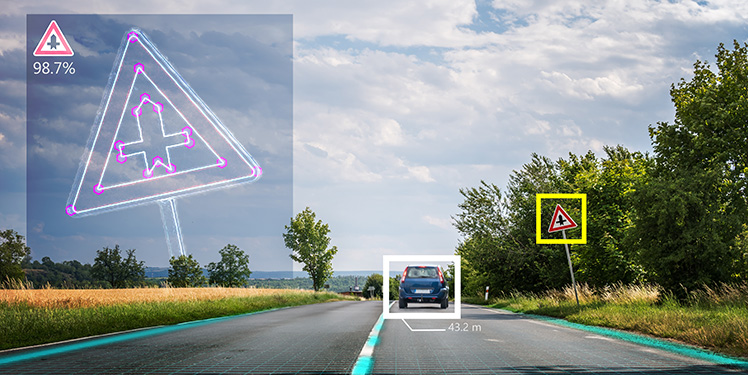

Immer mehr Produkte enthalten Komponenten, die auf maschinellen Lernverfahren und künstlicher Intelligenz basieren. Die Bandbreite reicht von Produkt- und Musikempfehlungen bei Onlinediensten, über Verkehrsschild- und Hinderniserkennung im Straßenverkehr bis hin zur Unterstützung von Radiologen bei der Krebsdiagnostik.

Obwohl einstige Zukunftsvisionen wie autonome Fahrzeuge in greifbare Nähe rücken, sind einige wichtige Fragen zum maschinellen Lernen und künstlicher Intelligenz noch nicht abschließend geklärt. Eine solche Frage ist beispielsweise, in welcher Form ein Nachweis der funktionalen Sicherheit erbracht werden kann. Die Frage stellt sich keineswegs nur für autonome Fahrzeuge, sondern spielt überall dort eine Rolle, wo ein Versagen einer maschinell erlernten Lösung hohe Risiken mit sich bringt – nicht nur, aber insbesondere für die körperliche Unversehrtheit von Menschen.

Warum tut sich das klassische Engineering damit schwer?

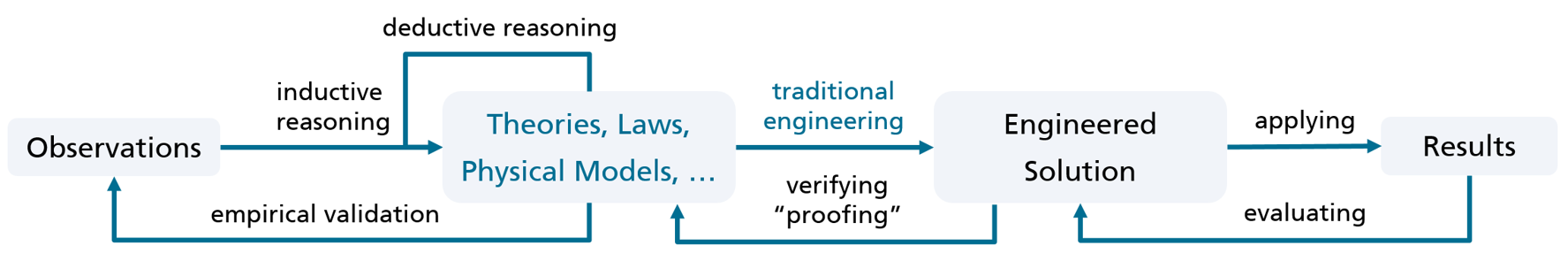

Um das Problem grundlegend zu verstehen, müssen wir gedanklich einen Schritt zurücktreten und kurz rekapitulieren, wie Engineering bis dato funktioniert und was der Einzug von maschinellem Lernen und künstlicher Intelligenz in die zu entwickelnden Produkte bewirkt.

Im klassischen Engineering werden zur Problemlösung etablierte Gesetze und Modelle angewandt. Nehmen wir den Bau eines Hochhauses. Dort werden neben den Bedürfnissen der künftigen Nutzer und der Kreativität des Architekten Modelle zu physikalischen Gegebenheiten und Materialeigenschaften sowie weitere Regelwerke berücksichtigt, um ein nach dem Stand der Technik, statisch, energetisch und feuerschutztechnisch sicheres Gebäude zu bauen. Aussagen dazu werden im Planungsstadium gemacht und abgenommen.

Die in diesem Zusammenhang angewandten Gesetzmäßigkeiten, wie beispielsweise hinsichtlich der Verteilung von Traglast und Wärmeausbreitung, wurden zuvor in zahlreichen empirischen Versuchen weitestgehend als universell gültig validiert.

Bei der ingenieurmäßigen Problemlösung liegt der Fokus daher auf einer geschickten und korrekten Ausnutzung dieser Gesetzmäßigkeiten, um die gestellten Anforderungen zu erfüllen. So lässt sich eine Lösung häufig nach ihrer initialen Konzeption auf Basis der zugrundeliegenden Gesetzmäßigkeiten verifizieren, beispielsweise, ob die zugrundeliegende Baustatik die benötige Tragfähigkeit bietet.

Verallgemeinern lässt sich der Umstand, dass der frühzeitige konzeptionelle Nachweise bestimmter Eigenschaften ein wichtiges Merkmal einer ingenieurmäßigen Lösung ist. Da dies natürlich nicht durchgängig für alle Eigenschafen einer Lösung gilt, ist deren Umsetzung in den meisten Disziplinen von zusätzlichen Evaluationsaktivitäten begleitet. Bei Bauwerken sind dies Begehungen und Abnahmen, bei Automobilen beispielsweise Simulationen und Testfahrten.

Auch das Software Engineering folgt – vergleichbar dem Systems Engineering – weitgehend der Tradition der ingenieurmäßigen Konzeption von Lösungen. Ein Problem wird konkretisiert, in Teilprobleme zerlegt und die sukzessiv verfeinerte Lösung letztlich mittels geeigneter Algorithmen durch die Entwickler respektive Software-Ingenieure im Programmcode abgebildet.

Was unterscheidet datengetriebene von ingenieurmäßigen Lösungen?

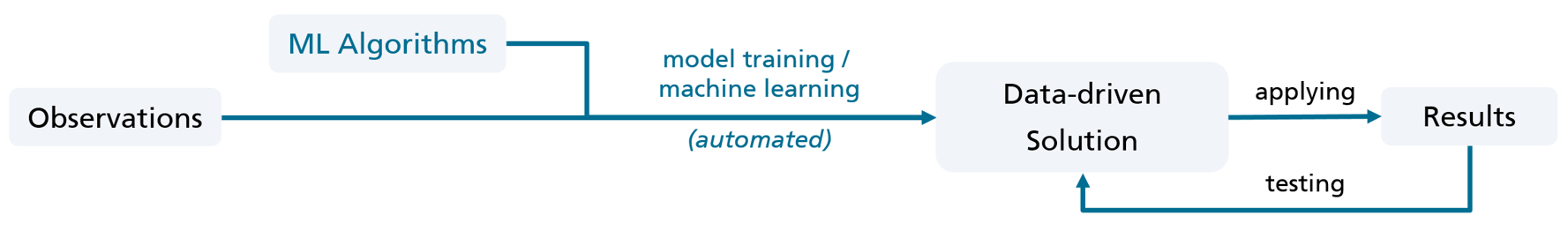

Datengetriebene Problemlösungen, wie sie durch die Anwendung von maschinellen Lernverfahren entstehen, weisen in ihrer Entstehung einen fundamentalen Unterschied zu ingenieursmäßigen Lösungen auf. Anstelle des Menschen, der Gesetzmäßigkeiten zur Problemlösung geschickt und auf Erfahrung basiert kombiniert, generalisiert der maschinelle Lernalgorithmus aus den bereitgestellten Beobachtungsdaten ein datenbasiertes Modell als spezifische Lösung für die konkrete Problemstellung. Beispiel für solche Problemstellungen sind das Erkennen von Verkehrsschildern im Straßenverkehr, aber auch die Identifikation von Tumoren auf CT-Bildern. Zugrundeliegende Gesetzmäßigkeiten und Zusammenhänge brauchen bei dieser Art der Problemlösung dem Ingenieur im Vorfeld nicht bekannt zu sein. Verkürzt könnte man sagen, datengetriebene Lösungen nehmen eine Abkürzung, indem sie den wissenschaftlichen Schritt der Theoriebildung und experimentellen Validierung überspringen.

Datengetriebene Lösungen besitzen daher gegenüber ingenieurmäßigen Lösungen sowohl Vorteile als auch Nachteile. So lassen sich mittels maschinellen Lernverfahren insbesondere auch Lösungen für Probleme bereitstellen, die entweder derzeit ingenieurmäßig nicht sinnvoll lösbar sind oder deren aktuelle ingenieurmäßige Lösungen bezüglich Effektivität und Effizienz bei weitem übertroffen werden. Aktuelle Beispiele sind die Identifikation von Objekten in Bilddaten, die Erkennung menschlicher Sprache wie auch die automatische Übersetzung von Texten.

Nun könnte man die angewandten maschinellen Lernverfahren gedanklich mit den Gesetzmäßigkeiten im traditionellen Engineering gleichsetzen, da diese ebenfalls durch den Ingenieur geeignet ausgewählt und zur Lösung eines Problems angewendet werden. Den potenziellen Nachteilen einer datengeriebenen Lösung könnte dementsprechend durch ein ingenieurmäßiges Vorgehen bei Erstellung und Einsatz der Algorithmen entgegnet werden.

Da die Algorithmen der maschinellen Lernverfahren selbst jedoch keine Gesetzmäßigkeiten darstellen, entziehen Sie sich einer generellen empirischen Validierung. Auch ist bei datengeriebenen Lösungen nicht der Ingenieur derjenige, der die Lösung konzipiert, vielmehr gibt er einen oder mehrere Algorithmen vor, die dann anhand vorhandener Daten eine Lösung selbstständig „erlernen“, in dem sie aus den Daten ein passendes Modell abstrahieren.

Wie wichtig ist uns das „Warum“ bei datengetriebenen Lösungen?

Das Vorhandensein einer Begründung ist für Menschen ein wichtiges Akzeptanzkriterium. Nicht umsonst ist die Urteilsbegründung in Gerichtsverfahren gewöhnlich deutlich aufwändiger als die reine Urteilsfindung. Beim Einsatz aktueller maschineller Lernverfahren ist es im Allgemeinen jedoch schwierig, ein bestimmtes Ergebnis anhand der Berechnungen im zuvor erlernten Modell für einen Menschen nachvollziehbar zu begründen. Aktuell widmen sich interessante Forschungsansätze der Verbesserung dieser Situation, in letzter Konsequenz beißt sich an dieser Stelle jedoch die sprichwörtliche Katze in den Schwanz. Sobald die Ergebnisse einer maschinell erlernten Lösung vollständig mittels Begründungen nachvollziehbar sind, ist das Problem auch ingenieurmäßig modellierbar und damit lösbar. Solang diese Tiefe an Verständnis nicht erreicht ist, handelt es sich hingegen im besten Fall um eine Plausibilisierung der Ergebnisse.

Wenn wir also von aktuellen Fortschritten im Bereich künstlicher Intelligenz und des maschinellen Lernens profitieren wollen, müssen wir voraussichtlich damit leben, dass wir die Frage nach dem „warum“ hinter der Lösung nicht immer befriedigend beantworten können.

Was bleibt? Wissen um die Unsicherheit.

Was auch bei datengetriebenen Lösungen erstrebenswert bleibt, ist – neben dem Ausschluss erkennbarer Fehlerquellen – eine möglichst verlässliche Einschätzung der Unsicherheit im bereitgestellten Ergebnis. Eine datengetriebene Komponente zur Verkehrsschilderkennung sollte beispielsweise nicht nur die Information liefern, dass ihre Auswertung auf das Vorhandensein eines Vorfahrtsschildes schließen lässt, sondern auch Information zur im Ergebnis enthaltenen Unsicherheit und seiner Konfidenz in deren Bestimmung. Das könnte im Beispiel wie folgt aussehen „unter Berücksichtigung der aktuellen Licht- und Wetterverhältnisse sowie dem Verschmutzungsgrad der Frontkamera wurde das Schild auf einem Konfidenzniveau von 0.95 mit einer Wahrscheinlichkeit von > 98,6 % als Vorfahrtsschild erkannt“. Bei der Unsicherheit im Ergebnis spielen hierbei neben der generellen Qualität des Modells auch der aktuelle Einsatzkontext wie auch die Qualität der zur Verfügung stehenden Daten eine wichtige Rolle [1]. Es ist leicht nachzuvollziehen, dass beispielsweise das Wissen um schlechte Lichtverhältnisse oder eine verschmutzte Kameralinse zwar wenig Informationsgewinn bei der korrekten Bestimmung eines Verkehrsschilds liefern. Sie helfen jedoch, die Unsicherheit im bereitgestellten Ergebnis akkurater zu beurteilen und damit dem diese Information verwendenden Gesamtsystem bessere Entscheidungen zu treffen.

Eine datengetriebene Lösung muss dementsprechend umfassend und empirisch sauber auf für den geplanten Einsatzkontext repräsentativen und bezüglich Qualität und Herkunft annotierten Daten getestet werden. Wie hierbei Unsicherheitsquellen im Rahmen der Entwicklung kollaborativer eingebetteter Systeme geeignet identifiziert, modelliert und quantifiziert werden können, damit wird sich unter anderem im vom BMBF geförderten Konsortialprojekt CrESt beschäftigt.

Infos zu aktuellen Projekten und dem Leistungsangebot des Fraunhofer IESE zur Entwcklung datengetriebener Lösungen finden Sie unter: www.iese.fraunhofer.de/de/competencies/data.html

Weitere Infos und Input zum Thema gewünscht?

Wenn Sie mehr zum Stand der Technik und den Herausforderungen bei der Absicherung von KI in sicherheitskritischen Systemen erfahren wollen, besuchen Sie gerne unsere im Jahr 2022 neukonzipierte 4-tägige Weiterbildung zum zertifizierten »Data Scientist Specialized in Assuring Safety«.

[1] Michael Kläs and Anna Maria Vollmer, “Uncertainty in Machine Learning Applications – A Practice-Driven Classification of Uncertainty”, First International Workshop on Artificial Intelligence Safety Engineering Sept 18th, 2018, Västerås, Sweden.

Martin Horeni sagt:

Letztlich sind neuronale Netze im einfachsten Fall mehrdimensionale Regressionsanalysen und mit diesen tun sich Ingenieure – mindestens im 2D-Raum – ja auch nicht so schwer (Stichwort „Trendlinie“). Mit KI kann man Probleme eben noch von einer anderen Seite anschauen und das ist gut für Wissenschaftler! Und ob das Modell sauber begründet werden kann spielt in der Praxis weniger eine Rolle wenn das (Prognose-) Ergebnis passt…

Martin Horeni

Dr. Michael Kläs sagt:

Vielen Dank für Ihre Anmerkungen! Ihrer Aussage „Mit KI kann man Probleme eben noch von einer anderen Seite anschauen und das ist gut für Wissenschaftler!“ würde ich mich klar anschließen, dies impliziert, dass Sie diese Methoden nutzen um ein Problem besser zu durchdringen. Sobald ein solches Verfahren jedoch beispielsweise Teil einer (sicherheits-)kritischen Funktionalitäten in einem System wird, stellt sich sehr wohl häufig die Frage: Kann ich verstehen und begründen wie die Prognoseergebnisse zustande kommen oder kann ich zumindest eine Abschätzung für die verbleibende Unsicherheit angeben? Das Verstehen und Begründen fällt hierbei bei einem tiefen neuronalen Netz, das Fußgänger auf Bildern erkennen soll, doch noch einmal deutlich schwerer als bei einer mehrdimensionalen linearen Regression mit einer Hand voll Eingabevariablen.