Die Automatisierung von technischen Systemen bis hin zur Autonomie ist einer der aktuellen Megatrends in der Industrie. Künstliche Intelligenz (KI) ermöglicht die Realisierung dieser Autonomie. Oftmals sind diese Systeme Bestandteile eines größeren Ökosystems, in dem durch ein Fehlverhalten eines solchen autonomen Systems wirtschaftlicher oder gar persönlicher Schaden entstehen kann. Dies erfordert spezielle Maßnahmen zur Garantie der funktionalen Sicherheit von Systemen mit KI-Anteilen. Bestehende Verfahren, wie sie durch Standards wie IEC 61508 vorgegeben werden, sind nur noch bedingt anwendbar oder umfassen nicht den vollen Umfang der Problematik der funktionalen Sicherheit von autonomen Systemen. Als eine der weltweit führenden Forschungsabteilungen zum Thema Funktionale Sicherheit arbeiten wir sowohl im Rahmen nationaler und internationaler Projekte als auch bilateral mit unseren Industriepartnern an der Lösung dieser Probleme.

Safety für autonome Systeme

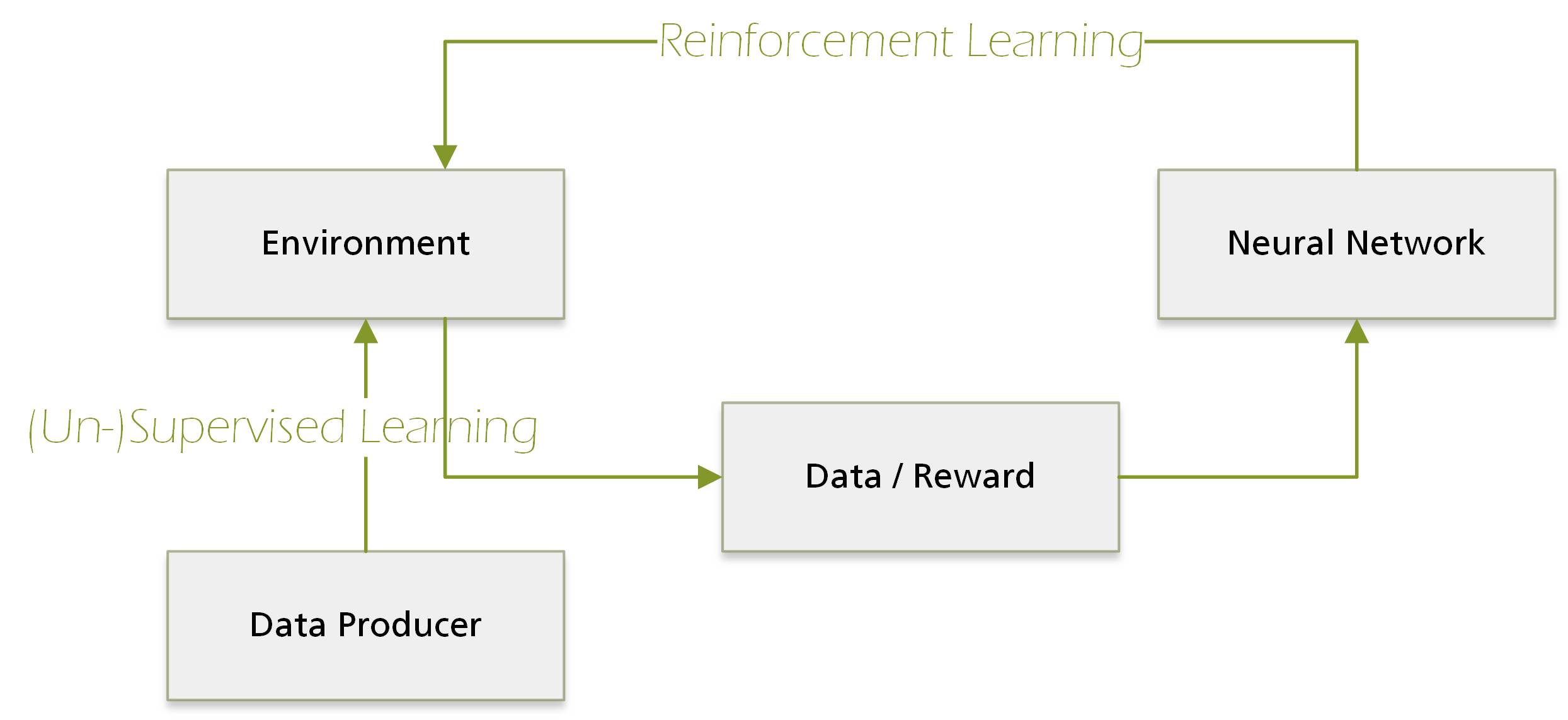

Trustworthy Deep Learning

Die Realisierung von autonomen Systemen in offenen Umgebungen wird den Einsatz von Verfahren des Deep Learning mit künstlichen neuronalen Netzen erfordern. Diese Verfahren zeigen für viele Aufgaben, wie beispielsweise die Klassifikation von Objekten in Bildern, eine hervorragende Performanz. Aufgrund des Fehlens einer expliziten Spezifikation der zugrundeliegenden Algorithmen (maschinelle Lernverfahren lernen aus Beispielen oder durch Ausprobieren) sind bestehende Verfahren zur Verifikation, wie beispielweise Code Reviews, nicht mehr durchführbar. In einer aktuellen, durch das Land Rheinland-Pfalz geförderten Kooperation arbeiten wir gemeinsam mit dem Fraunhofer-Institut für Techno- und Wirtschaftsmathematik ITWM und dem Deutschen Forschungszentrum für Künstliche Intelligenz (DFKI) am Aufbau eines Katalogs von Verfahren und einer darauf aufbauenden Methodik zur Steigerung der Vertrauenswürdigkeit von Anwendungen des Deep Learning.

Wir bringen diese Verfahren im Kontext Ihrer Anwendung zum Einsatz und erhöhen somit die Vertrauenswürdigkeit Ihrer durch Deep Learning implementierten Funktionalität.

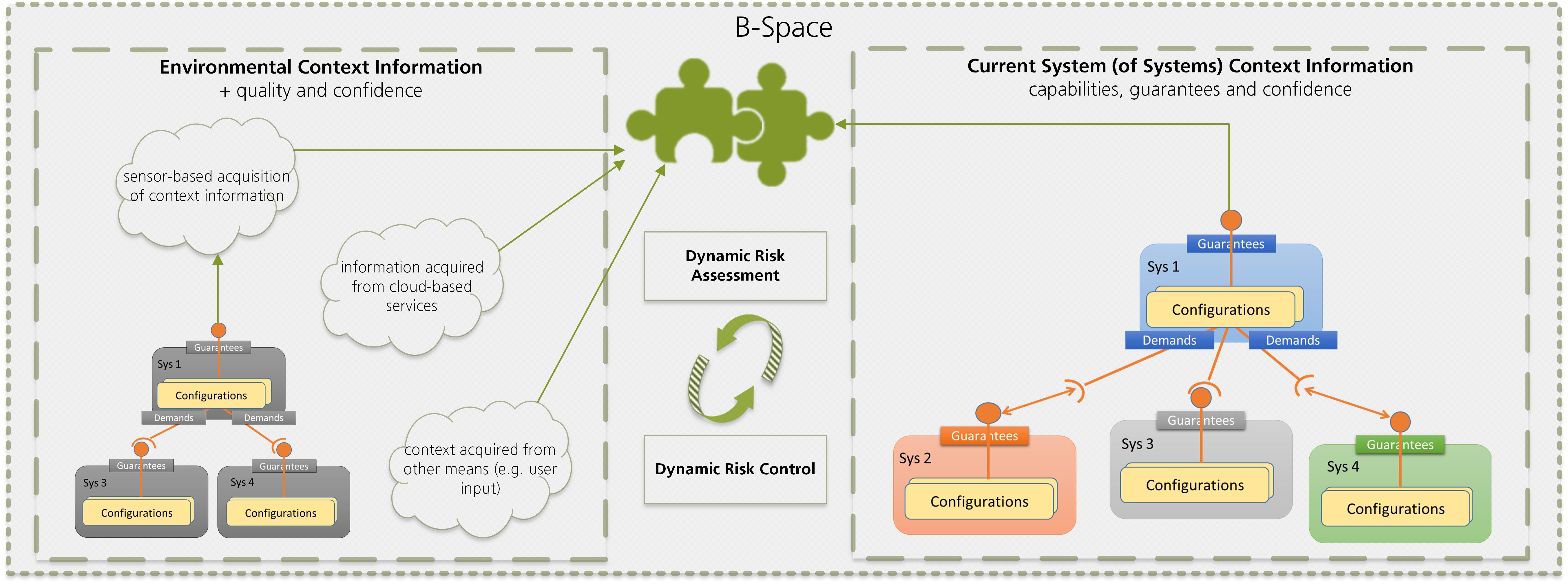

Dynamic Risk Management

In offenen Umgebungen können Situationen auftreten, die bei der Entwicklung eines technischen Systems nicht berücksichtigt wurden. Die Fähigkeit, mit solchen Situationen umzugehen und auch in diesen ein verlässliches Verhalten zu zeigen, wird als Resilienz bezeichnet. Unter dem Begriff des dynamischen Risikomanagements erarbeiten wir in dem europäischen Forschungsprojekt SECREDAS und im Rahmen des Resilient Intelligence Think Lab ENARIS® Methoden für die risikogerichtete Laufzeit-Rekonfiguration zur Steigerung der Resilienz. Um die Anwendung solcher Verfahren im Bereich sicherheitskritischer Systeme zu ermöglichen, muss hier insbesondere auch auf die Möglichkeit einer Zertifizierung geachtet werden. Hierzu bauen die Konzepte des dynamischen Risikomanagements auf unseren bereits etablierten Ansätzen zu Laufzeit-Safety-Zertifikaten auf.

Für Ihre vernetzten, sicherheitskritischen Anwendungen im offenen Kontext ermöglicht der Transfer unserer Arbeiten hochperformante Lösungen mit garantierten Safety-Eigenschaften.

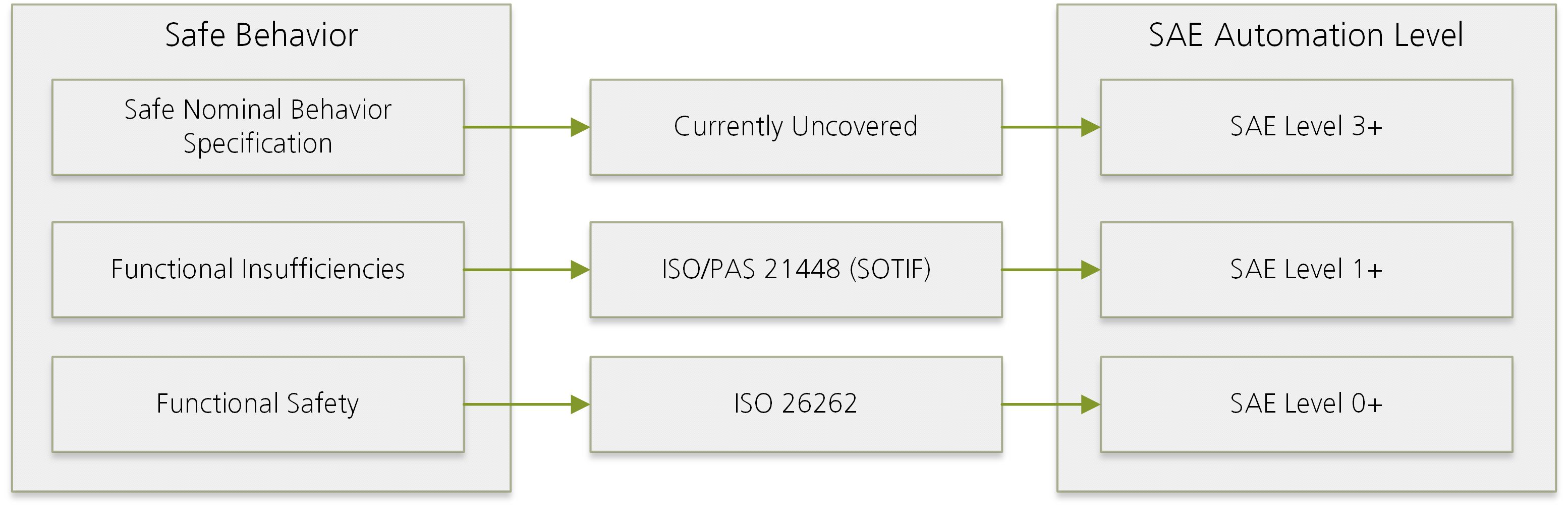

Multi-Aspect Safety Engineering

Mit dem Aufkommen von zunehmend automatisierten und vernetzten Systemen ergibt sich aktuell die Situation, dass die etablierten Methoden und Standards zur Entwicklung und Gewährleistung von Sicherheit nicht Schritt halten und keine ausreichende Unterstützung bieten. Neue Methoden und Standards sind also nötig, um die normativen Anforderungen an kritische Systeme festzulegen. Erst durch den Abgleich eines technischen Systems mit bestehenden Standards kann entschieden werden, ob dieses System die nötige Produktreife besitzt. Aktuell wird die Realisierung von Systemen höherer Automatisierungsstufen daher oft nicht durch technische Herausforderungen verhindert, sondern durch offene Fragestellungen bezüglich der Zertifizierung und Freigabe dieser Systeme. Zur Bearbeitung dieser Herausforderungen sind wir mit OEMs und Zulieferern aus der Automobilbranche in einem der Nachfolgerprojekte des PEGASUS-Projekts aktiv.

Wir bringen unsere Kompetenz im Bereich der aktuellen Standardentwicklung und darüber hinaus in Ihre Projekte zur marktreifen Realisierung von Systemen mit hoher Automatisierungsstufe ein.

Das könnte Sie auch interessieren:

Lesen Sie mehr über das Potenzial von Autonomen Systemen: