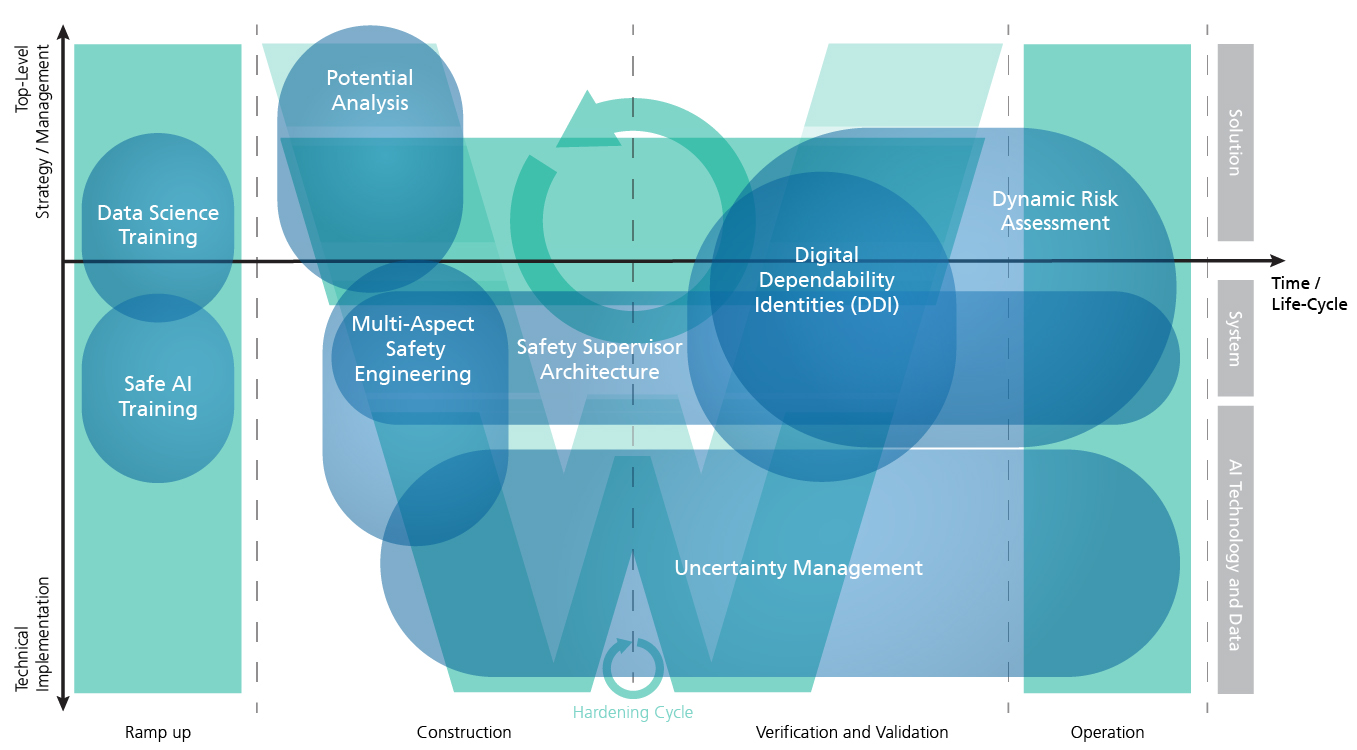

KI-Potenzialanalyse

Im Rahmen von Potenzialanalysen wird der Mehrwert von KI für ein Unternehmen herausgearbeitet. Mit etablierten Vorlagen (wie Value Proposition oder BMC) werden die Auswirkungen von KI auf das Geschäftsmodell ausgearbeitet. Wir stellen für einen Anwendungskontext relevante Normen, Standards und Qualitätsrichtlinien zusammen und zeigen auf, welche KI-Systeme heute schon möglich sind und welche Vorgaben man in Zukunft in Abhängigkeit von der Kritikalität einhalten muss. Dabei wird auch die Lücke zwischen der aktuellen Aufstellung des Unternehmens und der zukünftigen Ausrichtung ermittelt und eine Strategie erarbeitet. Im Rahmen von Prototypen werden vielversprechende Anwendungsszenarien in Bezug auf Profitabilität, Nachfrage und technische Umsetzbarkeit evaluiert (z.B. im Hinblick auf die Verfügbarkeit von Daten und die Güte der Vorhersage).

Multi-Aspect Safety Engineering

Insbesondere für die Entwicklung von hochautomatisierten und Autonomen Systemen spielt nicht nur die funktionale Sicherheit (ISO 26262), sondern auch die Sicherheit der beabsichtigten Funktionalität (SOTIF, ISO/PAS 21448) und die systematische Entwicklung eines sicheren Nennverhaltens eine wichtige Rolle. In einem modellbasierten Ansatz nutzen wir moderne Methoden und Techniken des Safety Engineerings, um das System ganzheitlich zu modellieren, zu analysieren und die gefundenen Risiken zu beherrschen. Die Argumentation, dass das System verlässlich ist, erfolgt dabei über Assurance- oder Safety-Case-Analysen. Über Evidenzen wird argumentiert, dass sich das System bzgl. des Assurance bzw. Safety Cases entsprechend so verhält, dass die Risikoakzeptanzschwelle nicht überschritten wird.

Safety-Supervisor-Architektur

Ein weiteres zentrales Element für die Verlässlichkeit des Systems stellt die Systemarchitektur dar. Hier gibt es z.B. Architekturen, die eine Art Sicherheitscontainer um die KI legen. Safety-Supervisor- oder Simplex-Architekturen überschreiben die KI-Entscheidung, falls diese zu einem gefährlichen Verhalten des KI-Systems führen würde. Dazu ist es wichtig, z.B. die Unsicherheit der KI-Empfehlung unter bestimmten Nutzungsbedingungen zu kennen und darauf basierend das Risiko einer fehlerhaften Entscheidung zu ermitteln. Solche Ansätze sind für Machine-Learning-Komponenten im Allgemeinen interessant und besonders wichtig, wenn es sich um KI-Systeme handelt, die über ihre Lebenszeit hinweg weiter lernen und daher ihr Verhalten anpassen können. Da es potenziell unmöglich ist, zum Entwurfszeitpunkt eines KI-Systems zu wissen, welche Daten die KI als Grundlage für weiteres Lernen verwendet, müssen entsprechende Leitplanken für das Verhalten definiert und in das System eingebaut werden.

Digital Dependability Identities (DDI)

Eine Digital Dependability Identity (DDI) ist ein Instrument, um zentral alle Spezifikationen, die für die Systemverlässlichkeit relevant sind, einheitlich und austauschbar zu dokumentieren und die Spezifikation mit einem System bzw. Systemteil auszuliefern. Dies ist insbesondere dann wichtig, wenn Systemteile unterschiedlicher Hersteller/Zulieferer entlang der Lieferkette integriert werden müssen bzw. falls eine dynamische Integration verschiedener Systemteile zur Laufzeit erfolgt (wie beim kollaborativen Fahren). Das Rückgrat der DDI ist ein Assurance Case, der alle Spezifikationen strukturiert und miteinander verknüpft und so argumentiert, unter welchen Bedingungen das System verlässlich arbeitet. Die Art der Evidenzen in der Argumentationskette ist ganz unterschiedlich. Sie können die Sicherheitsarchitektur betreffen oder das Management von Unsicherheiten der KI-Komponente, beispielsweise den Nachweis, dass man Daten verwendet, welche den intendierten Verwendungskontext ausreichend abdecken.

Dynamic Risk Management (DRM)

DRM ist ein Ansatz zur kontinuierlichen Überwachung des Risikos eines Systems und seines geplanten Verhaltens sowie seiner sicherheitsrelevanten Fähigkeiten. DRM überwacht das Risiko, optimiert die Leistung und gewährleistet die funktionale Sicherheit durch ein kontinuierliches Management, das sich auf Laufzeitmodelle stützt. Ein Bestandteil des DRM von KI-basierten Systemen kann auch die Ausgabe eines Uncertainty Wrappers sein.

Uncertainty Management

Unsicherheit ist bei datenbasierten Lösungen ein inhärentes Problem und kann nicht ignoriert werden. Der Uncertainty Wrapper ist ein ganzheitlicher, modellunabhängiger Ansatz zur Identifizierung situativ zuverlässiger Prognosen von Unsicherheiten in KI-Komponenten. Unsicherheiten können neben dem KI-Modell selbst auch aus den Eingabedaten und dem Verwendungskontext kommen. Der Uncertainty Wrapper kann einerseits bei der Entwicklung des KI-Modells eingesetzt werden, um die identifizierten Unsicherheiten durch entsprechende Maßnahmen zu beherrschen und das Modell sicherer zu gestalten. Andererseits ermöglicht der Wrapper zur Laufzeit des KI-Systems eine ganzheitliche Betrachtung der aktuellen Unsicherheit der KI-Komponente. Die Einschätzung kann wiederum von einem Sicherheitscontainer verwendet werden, um die KI zu übersteuern und das System in einen risikoärmeren Zustand zu überführen.

Trainings

Nicht zuletzt sind wir auch in der Qualifizierung entsprechender Kompetenzen im Unternehmen aktiv: von Enlightening Talks für das Management über Weiterbildungsprogramme zum Data Scientist bis hin zu Spezialschulungen für verlässliche KI-Systeme (z.B. Safe-AI-Schulung).

Zurück zur Übersicht